Man könnte meinen, es wäre einfach, die Qualität wissenschaftlicher Arbeit zu bestimmen. Gute Forschung ist gut und schlechte Forschung ist schlecht und wer gute Forschung publiziert ist ein guter Wissenschaftler und bekommt gute Jobs. Aber in der Realität läuft es anders. Es kommt da nicht so sehr auf die Qualität der Arbeit selbst an, sondern auf die Zeitschrift, in der sie veröffentlicht worden ist. Oder auf die Anzahl der Publikationen, die man produziert. Das ist in gewissem Sinne auch verständlich, denn es ist schwer die Qualität einer wissenschaftlichen Arbeit objektiv zu bestimmen. Oft weiß man schlicht und einfach noch nicht, ob sich die Arbeit irgendwann als wichtig herausstellen wird oder nicht. Oder es sind nur ein paar Spezialisten überhaupt in der Lage, die Qualität der Arbeit zu beurteilen. Leider hat sich auch in der Wissenschaft der Drang zu scheinbar einfachen Kennzahlen durchgesetzt und deswegen dominiert dort heute der Impact Factor. Diese Zahl unterscheidet “gute” von “schlechten” wissenschaftlichen Zeitschriften und je mehr Arbeiten man in einer “guten” Zeitschrift publizieren kann, desto besser wird auch die eigenen Karriere beurteilt. An vielen Universitäten wird sogar das Budget der einzelnen Institute anhand des Impact Factors der Mitarbeiter berechnet. Wer in den “guten” Zeitschriften veröffentlicht, bekommt mehr Geld das den anderen, die nur in “schlechten” Journals publizieren abgezogen wird.

Das ist natürlich ein klein wenig absurd. Der Impact Factor soll ja eigentlich die “Bedeutung” einer Zeitschrift messen. Je öfter andere Zeitschriften Artikel eines bestimmten Journals zitieren, desto größer ist der Impact Factor. “Wichtige” Zeitschriften werden oft zitiert; “unwichtige” dagegen kaum und deswegen müssen auch die Forschungsergebnisse in den “wichtigen” Zeitschriften wichtiger sein…

Diese Art der Beurteilung hat vielleicht noch vor ein paar Jahrzehnten Sinn gemacht, als es kein Internet gab. Damals musste man tatsächlich noch die Zeitschriften selbst lesen. Man musste die entsprechenden gedruckten Hefte in die Hand nehmen, darin blättern und nach interessanten Neuigkeiten suchen. Und natürlich kann man nicht alle Zeitschriften regelmäßig lesen; dafür gibt es einfach zu viele. Daher haben sich die diversen Zeitschriften für spezialisierte Forschung entwickelt; eigene Journals für Himmelsmechaniker; für die Erforschung großer Seen, für Dendrochronlogie oder chemischen Müll. Es haben sich aber auch “wichtige” Zeitschriften entwickelt, die allgemein die bedeutendsten Forschungsergebnisse publizieren. Wer dann ein “Nature” oder “Science” Heft las, konnte sicher sein, zumindest über die wichtigsten Entwicklungen in der Wissenschaft informiert worden zu sein.

Aber mittlerweile laufen die Dinge ja anders. Niemand mehr geht in die Bibliothek um dort in Zeitschriften zu blättern. Die Wissenschaftler benutzen verschiedene Online-Datenbanken um dort per Stichwort nach neuer Literatur zu suchen. Es ist egal, ob ein Artikel in “Nature” publiziert worden ist oder in den “Memorie della Società Astronomica Italiana” oder sonst irgendeinem bekannten oder weniger bekannten Journal. Alle wissenschaftlichen Arbeiten sind in der Datenbank und wenn sie relevant für mich sein könnten, werden sie bei meiner Suche auftauchen. Ich bin nicht mehr darauf angewiesen, dass “gute” Zeitschriften mir die “wichtigen” Artikel heraussuchen, denn dank dem Internet kann ich mittlerweile alle Artikel durchsuchen. Es gibt keinen vernünftigen Grund mehr, zwischen “wichtigen” und “unwichtigen” Journals zu unterscheiden und die ganze Sache mit dem Impact Factor hat keinen Sinn mehr, außer den Leuten vorzugaukeln es gäbe eine einfache und simple Methode, gute von schlechter Forschung zu unterscheiden.

Es ist auch ein Mythos, dass der Peer-Review bei den “guten” Journals besser wäre als anderswo. “Peer-Review” ist ja nichts, was von den Journals selbst abhängt. Die Gutachter, die beurteilen ob die Artikel veröffentlicht werden sollen oder nicht sind ja nicht bei den Zeitschriften angestellt. Das sind ganz normale Wissenschaftler die diese Gutachtertätigkeit kostenlos erfüllen. Jeder Wissenschaftler, der selbst Artikel publiziert wird früher oder später mal von einer Zeitschrift angeschrieben und um ein Gutachten gebeten werden (das passiert sogar mir ab und zu noch, obwohl ich schon seit einiger Zeit selbst keine wissenschaftlichen Facharbeiten mehr veröffentliche). Die Gutachter werden ausgewählt, weil sie in der Lage sind, das Thema des Artikels zu verstehen und angesichts der großen Spezialisierung die mittlerweile in der Wissenschaft vorherrscht ist die Gruppe potentieller Gutachter bei einem Artikel der bei einer “guten” Zeitschrift eingereicht wird identisch mit der Gruppe der Gutachter aus denen eine “schlechte” Zeitschrift auswählen kann. Wenn, dann ist die Qualität der Artikel bei den “guten” Journals eher schlechter. Denn damit die ihren hohen Impact Factor erhalten können, müssen sie immer spektakulärere Artikel veröffentlichen, die dann auch entsprechend oft zitiert werden. Das führt dazu, dass die Zeitschriften nicht immer so genau hinsehen, wenn sie die Chance haben, scheinbar beeindruckende Ergebnisse zu publizieren und dort mehr Müll durchrutscht als anderswo. Tatsächlich steigt die Anzahl der Arbeiten die zurück gezogen werden müssen mit dem Impact Factor an (siehe zum Beispiel “Retracted Science and the Retraction Index”, Fang et al 2011). Und von den ganzen Problemen mit dem mangelnden Zugang zu den Arbeiten will ich hier gar nicht reden…

Es ist schwierig, hier etwas zu ändern. Das System mit den Verlagen und den Zeitschriften hat sich mittlerweile festgesetzt obwohl es eigentlich nicht mehr nötig wäre. Dank dem Internet ist es egal, in welcher Zeitschrift eine Arbeit publiziert worden ist, wichtig ist nur, DAS sie publiziert wird. Die Wissenschaftler könnten ihre Arbeiten genau so gut gleich direkt bei irgendwelchen Datenbanken einstellen, ohne den Umweg über die Verlage zu gehen. Wissenschaftler bekommen für ihre Fachpublikationen ja kein Geld sondern müssen höchstens noch dafür bezahlen; sie würden also kein Geld verlieren sondern eher etwas sparen. Es wäre auch nicht mehr Arbeit nötig: Bei den Journals muss man die Artikel ja mittlerweile sowieso druckfertig layoutet einreichen. Und die Qualität? Wer überprüft dann, dass kein Müll publiziert wird? Es spricht eigentlich nichts dagegen, dass Peer Review auch ohne Verlage durchgeführt wird. Das könnte die wissenschaftliche Community genau so gut selbst organisieren. Momentan spielt jeder Wissenschaftler immer wieder mal freiwillig und unbezahlt den Gutachter für andere Arbeiten. Warum soll man nicht auch ab und zu mal freiwillig und unbezahlt den Editor spielen, eine eingereichte Arbeit zugewiesen bekommen, ein paar Gutachter auswählen und anhand der Ergebnisse entscheiden ob sie veröffentlicht wird oder nicht?

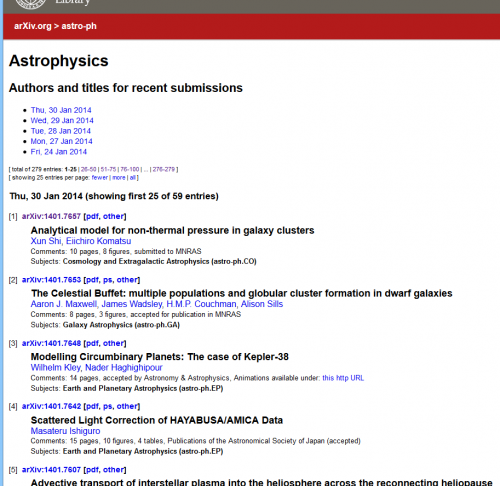

Man könnte natürlich auch das System des Peer Review völlig modifizieren. Man könnte einfach alle Artikel in einer Datenbank veröffentlichen (natürlich macht es Sinn, ein paar formale Kriterien einzufordern um den gröbsten Müll vorab zu selektieren) und den Review erst danach durch die Community durchführen zu lassen. Wenn man dann einen bestimmten Artikel in der Datenbank sucht, dann findet man eben nicht nur den eigentlichen Text sondern dazu auch gleich die gesammelten Kommentare der Kollegen (und natürlich kann man auch darauf achten, dass dort nicht einfach jeder Internettroll seine Kommentare abgibt, sondern nur angemeldete, namentlich identifizierte Benutzer). In gewissen Bereichen funktioniert das ja auch schon ein bisschen. Bei ArXiv stellen täglich hunderte Wissenschaftler ihre neuen Arbeiten ein und sie können dort von jedem frei gelesen werden. Meistens sind es Arbeiten, die zuerst schon anderswo in “echten” Journals publiziert worden sind. Aber immer öfter werden Arbeiten gleich direkt bei arXiv publiziert.

Ich schreibe heute eigentlich nur deswegen über dieses Thema, weil ich einen interessanten Artikel im Euroscientist-Blog gelesen haben. In “Mentors, mates or metrics: what are the alternatives to peer review?” schreibt Arran Frood wie sich die führenden Zeitschriften mit dem Problem der Messung wissenschaftlicher Qualität auseinandersetzen (oder nicht auseinandersetzen). Ich kann euch die Lektüre des Artikels nur empfehlen. Mich hat ein Satz dort ganz besonders zum Nachdenken gebracht:

“Perhaps it’s time to limit the number of papers or pages a scientist can publish.”

Das ist ein wirklich faszinierender Gedanke! So lange die Anzahl der Publikationen und deren Impact Factor weiterhin die Karrieren in der Wissenschaft dominieren, ist die Versuchung groß, bei den Veröffentlichungen mehr auf Quantität als auf Qualität zu achten. Das, was sonst in nur einem langen Artikel publiziert worden wäre, wird nun in zwei oder drei kürzere aufgespalten. Leute, die eigentlich nichts mit der eigentlichen Forschungsarbeit zu tun hatten, werden trotzdem als Ko-Autoren geführt, um deren Publikationsliste zu verlängern. Und so weiter. Wenn jeder Wissenschaftler pro Jahr nur eine bestimmte Anzahl an Artikeln (als Erstautor?) publizieren könnte, wäre das vielleicht ein Anreiz, wieder mehr auf die Qualität zu achten.

Ob das allerdings auch praktisch durchführbar ist, ist eine andere Sache. Wer sollte so eine Regeln durchsetzen? Wie sollte sie konkret aussehen? Vermutlich ist so eine Beschränkung utopisch – aber Variationen davon sind durchaus machbar. Schon seit 2010 darf man bei Förderanträgen an die Deutsche Forschungsgemeinschaft (DFG) nur noch maximal fünf Publikationen im Lebenslauf anführen. Regelungen dieser Art wären sicherlich auch bei Stellenausschreibungen, Berufungen bzw. Bewertungsverfahren aller Art sinnvoll.

Ich bin froh, dass ich bei diesem ganzen Spiel mittlerweile nicht mehr mitspielen muss. Aber es wäre trotzdem wichtig, dass sich die Dinge langsam ein wenig ändern. Die Ära der gedruckten Zeitschriften ist zumindest in der Wissenschaft schon lange vorbei. Sie erfüllen den Zweck, den sie früher erfüllt haben, schon lange nicht mehr. Es wäre an der Zeit, das zu akzeptieren und die veralteten Strukturen an die digitale Realität anzupassen!

Kommentare (32)