Im April wird ein neues Teleskop das erste Bild eines schwarzen Lochs machen! Diese Nachricht macht gerade die Runde – und obwohl sie nicht falsch ist, kann sie leicht missverstanden werden. Und damit am Ende niemand enttäuscht ist, wenn die Ergebnisse veröffentlicht werden lohnt es sich, ein wenig genauer nachzusehen, um was es dabei geht.

Das Teleskop, mit dem die Aufnahmen gemacht werden sollen ist das “Event Horizon Telescope (EHT)”. Dabei handelt es sich aber nicht um ein konkretes Gerät sondern eher um ein Projekt. Das EHT ist ein weltweiter Zusammenschluss von Radioteleskopen (aus Deutschland ist beispielsweise das Max-Planck-Institut für Radioastronomie mit dabei, aber auch die Goethe-Universität Frankfurt am Main).

Bis jetzt gibt es nur künstlerische Darstellungen von supermassereichen schwarzen Löchern (Bild: ESO/M. Kornmesser)

Radioteleskope werden deswegen verwendet, weil sie eine der wenigen Instrumente sind, mit denen man schwarze Löcher tatsächlich sehen kann. Beziehungsweise “sehen” kann. Denn im eigentlichen Sinn sehen wir natürlich nichts und das aus gleich zwei Gründen. Zum einen, weil man ein schwarzes Loch per Definition nicht sehen kann. Sonst wäre es ja kein schwarzes Loch: Aus der unmittelbaren Umgebung dieser Himmelskörper kann kein Licht entkommen und deswegen gibt es da auch nichts das man sehen kann. Zum anderen aber auch, weil das was wir sehen können (dazu gleich mehr) kein sichtbares Licht ist sondern Radiostrahlung.

Schwarze Löcher sind tatsächlich schwarz; sie geben keine Strahlung ab. Für ihre Umgebung gilt das aber nicht! Wenn sich in der Nähe des schwarzen Lochs Material – Gas und Staub – befindet, dann kann dieses Material in das schwarze Loch fallen. Schwarze Löcher sind zwar entgegen weit verbreiteter Vorstellungen keine Staubsauger die irgendwas “ansaugen”, aber es sind Himmelskörper die wie alle anderen Himmelskörper auch mit ihrer Gravitationskraft die Umgebung beeinflussen. In den Zentren von Galaxien, wo sich besonders massereiche schwarze Löcher befinden, geht es immer ein wenig gedrängter zu als in den Außenbereichen wo sich unsere Sonne befindet. Dort findet sich immer Material, das ins schwarze Loch fallen kann. Das tut es aber nicht auf direktem Weg sondern aus Gründen der Drehimpulserhaltung auf spiralförmigen Bahnen. Oder anders gesagt: So ein schwarzes Loch ist von einer Scheibe aus Gas und Staub umgeben, in der sich das Material mit hohen Geschwindigkeiten um das Loch bewegt. Durch diese Bewegung wird das Material aufgeheizt und gibt Strahlung ab; hauptsächlich Radio- und Röntgenstrahlung. Schwarze Löcher kann man nicht sehen – aber dafür leuchtet ihre Umgebung im Radiolicht um so heller. Wenn man etwas sehen will, sind Radioteleskope eine gute Wahl.

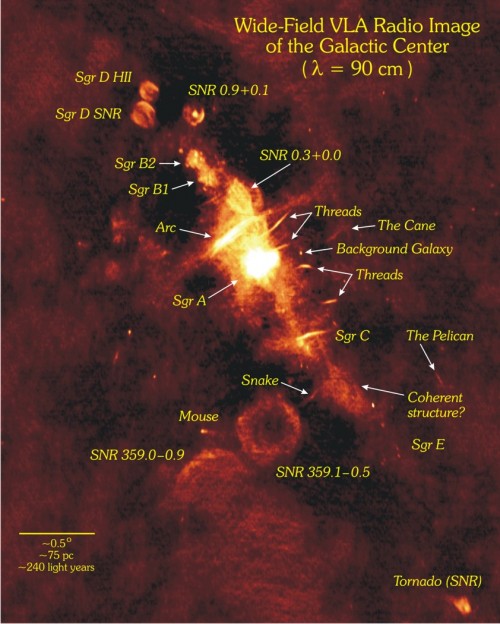

Das Zentrum unserer Milchstraße sieht im Radiolicht zum Beispiel so aus:

Man sieht hier jede Menge Quellen von Radiostrahlung (auch andere Objekte wie Sterne oder große Gaswolken leuchten im Radiolicht). In der Mitte findet man Sgr A (für “Sagittarius A”, benannt nach dem Sternbild Schütze) und irgendwo dort drin ist Sagittarius A*: Das supermassereiche schwarze Loch im Zentrum der Milchstraße.

Genauere Bilder zu machen ist schwer. Das Zentrum ist 26.000 Lichtjahre entfernt, das schwarze Loch selbst aber “nur” 44 Millionen Kilometer im Durchmesser (also etwas weniger als der Abstand zwischen Sonne und Merkur). Um dort tatsächlich Details zu erkennen, braucht man eine entsprechend gute Auflösung. Die ist mit den normalen Teleskopen nicht zu machen. Es geht aber mit einer Technik die man “Interferometrie” nennt.

Ein Lichtstrahl der durch die Öffnung eines Teleskops fällt wird immer ein wenig gebeugt. Wenn das Licht von einer Punktquelle kommt dann sorgt diese Beugung zwangsläufig dafür, dass man im Teleskop keinen Punkt sieht, sondern einen – mehr oder weniger großen – kreisförmigen Fleck. Das lässt sich nicht ändern, man kann das Problem aber umgehen. Man kann zum Beispiel zwei Teleskope benutzen, die beide das Objekt beobachten. Dann bringt man ihr Licht zur Interferenz. Die Lichtwellen werden sich an bestimmten Stellen verstärken, an anderen auslöschen: Man erhält ein typisches Interferenzmuster, ein Muster, dass man zum Beispiel auch sieht, wenn man zwei Steine ins Wasser wirft und die entstehenden Wellen betrachtet. Im Fall der beiden Teleskope würde man nun kein Beugungsscheibchen mehr sehen, sondern ein Interferenzmuster aus hellen und dunklen Linien. Ändert man den Abstand zwischen den beiden Teleskopen erhält man verschiedene Muster und diese kann man dann wieder zum ursprünglichen Bild kombinieren. Das gute daran ist: Die Auflösung wird nun nicht mehr durch den Durchmesser des Beugungsscheibchen bestimmt, sondern von der Breite der Interferenzstreifen. Die ist viel geringer und man kann viel kleinere Strukturen auflösen.

Das physikalische Prinzip der Interferometrie ist klar; die technische Umsetzung schwieriger. Bei optischen Teleskopen die im sichtbaren Licht beobachten ist diese Art der Beobachtung enorm kompliziert. Die Wellenlänge des Lichts ist hier sehr kurz und muss längere Zeit beobachten um genug Daten zu sammeln die interferieren können. Die Lichtwellenlängen lassen sich hier aber nicht “speichern”, man muss die Lichtstrahlen der Teleskope optisch zusammenführen und das geht nur, wenn die beiden Teleskope nicht allzu weit voneinander entfernt sind. Damit nimmt man sich aber einen großen Vorteil der Interferometrie: Denn der Abstand zwischen den Teleskopen entspricht gewissermaßen dem Durchmesser eines “virtuellen Teleskops”. Stehen die beiden Teleskope 100 Meter auseinander, dann kann man mit der Interferometrie ein 100 Meter großes Teleskop simulieren. Beträgt der Abstand 1000 Kilometer wird das virtuelle Teleskop entsprechend größer. Und so weiter.

Das Atacama Large Millimeter/submillimeter Array (ALMA); eines der vielen Teleskope die am EHT beteiligt sind (Bild: ESO/B. Tafreshi (twanight.org))

Bei Radiostrahlung sieht es anders aus. Hier kann man die Daten sehr gut aufzeichnen und abspeichern. Die gespeicherten Daten können dann später im Computer interferiert werden und deswegen macht es auch nichts, wenn die verwendeten Teleskope sehr weit entfernt voneinander sind. Oder eben, wie beim EHT, auf der ganzen Welt verteilt. Dieses virtuelle Teleskop von der Größe des ganzen Planeten sollte ein ausreichend gutes Auflösungsvermögen bieten, um das schwarze Loch im Zentrum der Milchstraße tatsächlich zu sehen. Oder eben zu “sehen”: Wenn alles klappt, dann sollte auf dem endgültigen Bild ein heller Ring (das strahlende Material aus der Umgebung) um einen dunklen Kreis (das schwarze Loch) abgebildet sein.

Bis das klappt ist aber noch ein wenig Arbeit nötig. Zwischen 5. und 14. April werden die Teleskope des EHT Daten sammeln. Die werden dann an das Haystack Observatory in Massachusetts in den USA transportiert (übrigens nicht übers Internet; dafür sind die Datenmengen zu groß – die Daten werden per Flugzeug auf Festplatten verschickt) wo ein Supercomputer darauf wartet, alles zu kombinieren und zu verarbeiten. Es wird Monate dauern, bis das Bild fertig ist. Aber dann werden wir tatsächlich das Zentrum unserer Milchstraße so genau sehen können wie nie zuvor. Und ein schwarzes Loch so gut sehen können, wie man es eben sehen kann. Oder “sehen”.

Kommentare (38)