In den Anfangszeiten dieses Blogs habe ich gelegentlich über NIMBY-getriebene Versuche berichtet, den Bau regenerativer Energieanlagen regional zu verhindern. Gerade vor dem Hintergrund der aktuellen Energiewende-Debatte lohnt sich dieser Blick in die kommunale Energiepolitik wieder, weshalb es hier im “Frischen Wind” künftig den “NIMBY der Woche” (dann und wann) geben wird. Den Einstieg macht dabei der Rat der Stadt Südliches Anhalt.

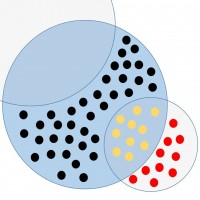

Auf einer Ratssitzung am Mittwoch wurde dort nämlich beschlossen, dass die 14.000-Einwohner-Stadt künftig keine neuen Flächen für Windparks mehr ausweisen wird. Wie die Mitteldeutsche Zeitung berichtet, stimmte einzig die CDU-Fraktion gemeinsam mit einem einsamen Überläufer aus den Reihen der Freien Wähler für die Ansiedlung neuer Windparks, während der Rest der Freien Wähler sowie die Linkspartei sich gegen die Ausweisung neuer Flächen entschieden haben – und das, obwohl bereits drei Windenergie-Investoren Interesse an entsprechenden Ansiedlungen bekundet hatten.

Begründet hat Dieter Marx, der Fraktionsvorsitzende der Linken – die in Sachsen-Anhalt noch im vergangenen Monat mit dem Slogan “Atomausstieg jetzt!” um Wähler geworben hatten – die Verweigerungshaltung seiner Partei mit einem besonders abenteuerlichen Argument: Weil in Sachsen-Anhalt schon so viele Windräder stehen, muss erst mal “der Westen” nachziehen, bevor vor Ort neue Baugenehmigungen erteilt werden könnten:

In Sachsen-Anhalt gebe es Marx zufolge bereits ein dichtes Netz von Windkraftanlagen, mehr sei den Einwohnern nicht zuzumuten. In den alten Bundesländern gebe es weniger Windparks, sie sollen erst einmal nachholen. “Schließlich gibt es im Westen nicht weniger Wind als bei uns.”

Und gegen dieses überzeugende Argument konnte niemand mehr punkten:

Olaf Feuerborn rechnete vor, dass allein durch neue Anlagen bei Quellendorf innerhalb von 20 Jahren 3,5 bis vier Millionen Euro Gewerbesteuer in den städtischen Haushalt fließen würden. Ein gewichtiges Argument in einer Zeit, in der im Südlichen Anhalt jeder Euro zweimal umgedreht werden muss, meinte auch Volker Richter, Fraktionschef Bürgermeister / CDU. Doch weder das noch der Verweis Feuerborns auf eine neue Lage nach dem Atomunfall in Japan konnten die Mehrheit im Stadtrat überzeugen.

Nein, auf die paar Millionen kommt es nun wirklich nicht an – und bevor hier irgendwas getan wird, um vor dem Hintergrund der Fukushima-Havarie einen regionalen Beitrag zum Atomausstieg zu leisten, sollen gefälligst erst mal die Wessis nachziehen. Vielleicht hätte die Gegenseite statt auf die kommunalen Finanzen und den Atomausstieg besser auf das Energiekonzept der Sachsen-Anhaltischen Linken verweisen sollen:

Die Nutzung der Windenergie hat sich in Sachsen-Anhalt rasant entwickelt, wird aber nun zunehmend durch raumordnerische Regelungen begrenzt. Es

ist aber erforderlich, landesplanerisch ausreichend Fläche für die Windkraftnutzung zu sichern und so auch das Ersetzen alter durch leistungsstärkere Anlagen (Repowering) zu unterstützen.

Aber ach, auch dort findet sich noch ein Hintertürchen für unwillige kommunale Planer:

Wir schlagen deshalb vor, ein Flächenziel für die Windenergienutzung von einem Prozent der Landesfläche (das sind 20.450 ha) festzuschreiben, das nicht unterschritten werden soll. Damit bleibt die Entwicklung der Windkraft im Rahmen der bisher bereits ausgewiesenen Flächen.

Und so bleibt am Ende doch alles beim Alten. Atomausstieg jetzt? Auf jeden Fall…nur gestemmt werden soll er doch bitte woanders…

Kommentare (77)