Hansen macht nun etwas sehr Einfaches. Er findet Äquivalente für die ja immer noch komplizierten und unanschaulichen Szenarien (siehe Bild 3): +2% Treibhausgasemissionen jedes Jahr entspricht dem RCP8.5 und somit (wir erinnern uns) einem business as usual (BAU) Szenario; BAU eben weil der exponentielle Anstieg der Vergangenheit in der Zukunft weiter fortgesetzt wird. Entsprechendes gilt für Hansens spontanes Emissionseinfrieren (also alles bleibt von heute auf morgen auf dem Niveau von 2015), welches irgendwo zwischen RCP6 und RCP4.5 liegt, und den beiden Szenarios, bei denen die Emissionen mehr oder minder drastisch eingeschränkt werden (-3% und -6% Emissionen pro Jahr), die beiden nahe dem RCP2.6 Szenario landen (siehe Bild 3).

Bei welchen atmosphärischen CO2 Werten landet man dann also im Jahre 2100? Hansen nimmt das einfache und gut getestete Berner Kohlenstoffmodell. Sein +2% per annum Emissions-Szenario endet z.B. bei katastrophalen 864 ppm im Jahr 2100, so keine Extraktionsmechanismen in Anschlag gebracht werden (dazu zum Schluss mehr). Nicht daß ich diese Möglichkeit von CO2 Werten über 800ppm im Jahre 2100 für sonderlich wahrscheinlich gehalten hätte oder nachwievor halte, aber das ist mittlerweile eine Ewigkeit her. Jetzt leben wir in der vierten Woche post Trump und man muss sagen: Alles ist möglich. Aber selbst ein -6% per Annum Szenario bewegt sich noch das gesamte 21te Jahrhundert um 400 ppm herum (und somit annähernd auf Eem Kurs).

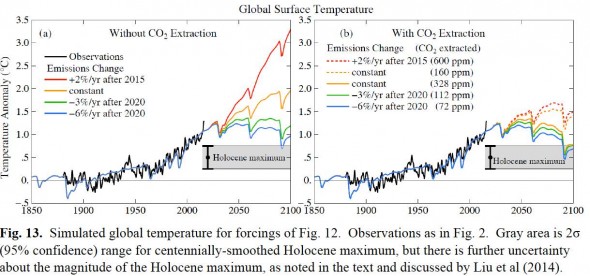

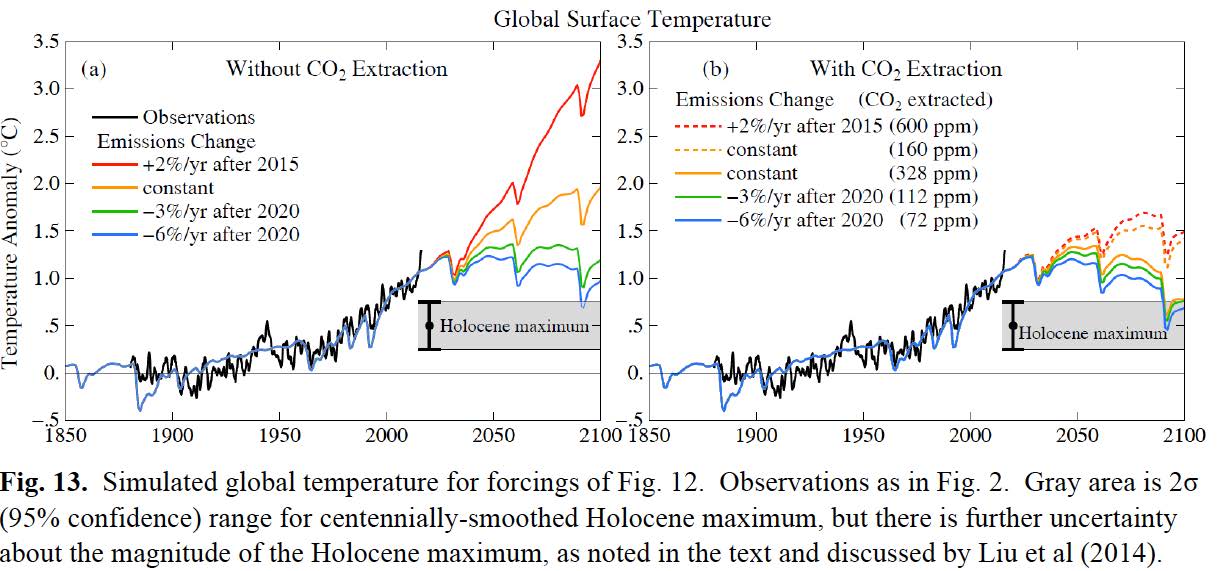

Bild 4: Temperaturverlauf bis 2100 berechnet mit den verschiedenen Emissionszenarien und einfachen Impulse-Response Funktionen.

Wie kann man jetzt diese einfachen Szenarien auf plausible Temperaturverläufe projizieren, ohne das volle Arsenal der IPCC Klimamodellle in Anschlag zu bringen? Eine sehr beliebte Antwort auf solche Fragen sind sogenannte Greens- oder Impulse-Response Funktionen. Dazu führt man eine Faltung (im Wesentlichen: erst Multiplizieren, dann Integrieren) der Klimasensitivität, einer prozentualen Klimagleichgewichtsfunktion, die man etwa von GCMs genommen oder sich sonstwie überlegt hat, und den jeweiligen Forcing-Szenarien, wie sie in Bild 3 zu sehen sind, durch. Die Klimagleichgewichtsfunktionen geben für die unterschiedlichen Zeitskalen (von 1 bis 100 Jahre) an, wie sehr das Klima bereits ins Gleichgewicht mit einer Strahlungsstörung gekommen ist. Beispielsweise ist also das Klima nach 100 Jahren zu etwa 75% mit einer Störung wie dem jetzigen Anstieg der Treibhaugase im Gleichgewicht. 25% wäre auch nach 100 Jahren noch “in der pipeline”, also im Ozean gespeichert und daher sozusagen “noch nicht spürbar”. Wieder ist das Interessante an dieser Beschreibung des Klimas und seiner Reaktion auf unterschiedliche Strahlungsforcings, wie unglaublich einfach diese Beschreibung ist und wie schnell sie auf jedem PC durchintegriert werden können.

Hansen berechnet seine vier Scenarien (+2%, konstant, -3%, -6% Emissionen) und kombiniert sie obendrein mit der Möglichkeit, relevante Mengen CO2 wieder aus der Atmosphäre zu extrahieren. Bild 4 zeigt, (1) daß ohne solche Extraktionsstrategien der globale Temperaturverlauf das gesamte 21te Jahrhundert oberhalb des Holozänen Optimums bleiben wird, (2) daß ein BAU Szenario (also +2% Emissionen jährlich) uns jenseits der Spezie Homo bekannten Temperaturbereiche führen sollte, (3) daß aber selbst ein instantanes Einfrieren der Emissionen auf dem aktuellen Stand uns noch über das Eem hinausführen wird.

Aus dieser Paläo-Perspektive brauchen wir also darüber hinaus Techniken, das bereits emittierte CO2 wieder aus der Atmosphäre zu bekommen. Um etwa im Jahr 2100 im Temperaturbereich des Holozänsv erbleiben zu können, müsste beim -6% Szenario immerhin noch 72ppm, beim BAU Szenario (+2%) gar gewaltige und utopische 768ppm extrahiert werden.

Hansen zitiert dann noch die letzten Abschätzungen, wieviel man denn realistischer Weise mit den verschiedenen Extraktionsethoden so herausholen könnte. Insbesondere Wiederaufforstungsmaßnahmen und ackerbauliche Techniken, die gleichzeitig die Böden verbessern UND ihren Kohlenstoffgehalt dabei erhöhen, sollen zusammen und global angewandt auf immerhin 100 GTC bis 2100 kommen. Allerdings ist eine Krux mit all diesen agrotechnischen Maßnahmen, daß sie meist zu Beginn gut funktionieren, man aber bald in eine Sättigung läuft, in der weit weniger Kohlenstoff extrahiert werden kann: Alte Bäume binden, selbst wenn sie weiter wachsen, immer weniger Kohlenstoff. Um dann trotzdem noch irgendwie Kohlenstoff in die Biosphäre zu pumpen, wurden daher schon solch großtechnischen Maßnahmen vorgeschlagen, die einmal rangewachsenen Wälder wieder in Holzkohle zu verwandeln, welche dann irgendwie verklappt und von der Atmosphäre ferngehalten wird. So würde man permanent anpflanzen, nachwachsen lassen, in Holzkohle verwandeln und diese dann aus dem System rausnehmen. Und das alles auf globaler Skala. An dieser Stelle überschreitet man dann die Schwelle zu den echten Geoengineering-Maßnahmen (also nicht nur ein bisschen Nachforsten und so). Eine etwa schlägt den globalen Austrag (also praktisch auf die gesamte globale Ackerbaufläche) von zermahlenem Silikat vor, um so die Verwitterung von Böden zu stimulieren und pro Jahr beachtliche 2-5GTC aus der Atmosphäre in den Ozean zu pumpen. So unsicher wie die möglichen Sekundärfolgen solcher Maßnahmen sind die veranschlagten Kosten: Irgendwo zwischen 200$ pro Tonne C und 3700$/tC schwanken die Kosten. Ich verliere mich an dieser Stelle ein wenig in den Zahlen: Wir sprechen also von einer Gesamtsumme von vielen Trillionen Dollar. Mich hat bei all dem überrascht, wie wenig aktuelle Machbarkeitsstudien es zu diesem Thema zu geben scheint. Hansen zitiert insbesondere aus einem Standardpaper von 2006.

Kommentare (33)