Fusionskraftwerke kommen in 50 Jahren, hieß es schon vor mehr als einem halben Jahrhundert. Doch immer noch ist unklar, wann das erste Fusionskraftwerk gebaut werden kann. Die bisher leistungsfähigsten Fusionsreaktoren stammen aus den späten 70er und frühen 80er Jahren. Ist die Forschung in der Zwischenzeit also keinen Schritt weitergekommen? Der Schein trügt. Es hat in dieser Zeit nicht nur Rückschläge gegeben, sondern auch eine ganze Menge Meilensteine. Auf ihrer Basis sind zwei bedeutende neue Forschungsprojekte entstanden: Wendelstein 7-X in Deutschland und das europäische Iter. Und die könnten endlich einen Durchbruch schaffen.

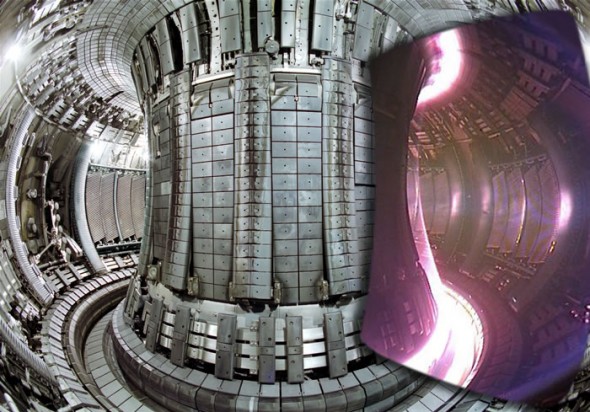

Dieser Artikel ist in einer etwas kürzeren Fassung auch auf golem.de erschienen. Das hier ist der “Director’s Cut” mit einigen Ergänzungen am Anfang und am Ende. Das Titelbild zeigt das innere des Joint European Torus, noch mit den alten Wänden aus Graphit. Wesentlich zum Artikel beigetragen haben natürlich meine beiden Gespräche mit Alf Köhn.

Der Weg zur Entstehung dieser beiden Forschungseinrichtungen ist eine Geschichte von Misserfolgen: von naiven Vorstellungen über Plasmaphysik über plötzlich gestrichene Forschungsgelder für fertige Anlagen bis zu Problemen in der Organisation beim Bau neuer Fusionsreaktoren. Aber sie ist auch eine Geschichte von aufregenden Erkenntnissen.

Was braucht ein Fusionskraftwerk?

Fusionskraftwerke sollen in der Zukunft die Energieprobleme der Menschheit lösen, da sie durch kontrollierte Kernfusion eine Menge Energie erzeugen sollen. Kein Wunder also, dass mit Mitteln in Milliardenhöhe weltweit daran geforscht wird. Doch die Voraussetzungen für einen Fusionsreaktor sind schwer zu erfüllen.

Der Reaktor für ein Fusionskraftwerk, wie es etwa aus dem Iter-Projekt entstehen soll, muss ein Gas aus Deuterium und Tritium bei etwa 100 Millionen Grad und etwa 10 Bar Druck kontrolliert in der Schwebe halten, ohne dass zu viel Energie aus dem Gas verloren geht. Das ist überhaupt nur möglich, weil sich bei solchen Temperaturen die Elektronen von den Atomkernen gelöst haben und frei beweglich sind. Es ist damit ein Plasma, das auf elektrische und magnetische Felder reagiert.

Das ist natürlich nicht in einem einfachen Behälter möglich. Die Teilchen im Gas würden gegen die Wand stoßen, ihre Energie abgeben und sofort wieder abkühlen. Deswegen ist es hilfreich, dass die Ionen und Elektronen in einem Plasma elektrisch geladen sind. Deshalb können sie von elektrischen Feldern und Magnetfeldern beeinflusst werden, ohne mit einer Behälterwand in Berührung zu kommen. Das stellte sich aber bald als große Herausforderung heraus.

Anders als in einem idealen Gas können Kräfte in einem Plasma nicht nur durch Stöße zwischen den Bestandteilen übertragen werden, sondern auch auch durch elektrische Ladungen über große Entfernung. Das macht es zwar überhaupt erst möglich, so ein Plasma in einem Fusionsreaktor schweben zu lassen, aber sein Verhalten ist auch viel schwerer zu berechnen. Die mathematische Beschreibung des Verhaltens eines Plasmas ist zwar im Prinzip möglich, aber nicht sehr nützlich ohne Computer die Differentialgleichungen schnell mit finiten Elementen berechnen können.

Solche Computer gab es noch nicht. Außerdem macht es die hohe Temperatur des Plasmas schwierig, genaue Messdaten zu erhalten, mit denen die mathematischen Modelle aufgestellt werden können. Die Entwicklung von Fusionsreaktoren musste deshalb von Anfang an experimentell angegangen werden. Es blieb den Pionieren also nichts anderes übrig, als Experimente zu bauen und zu schauen, was passieren würde. Im Detail gilt das bis heute, auch wenn die Computermodelle immer besser werden.

Dem Plasma einheizen

Die beiden großen Probleme bei der Kernfusion sind das Erhitzen des Plasmas und der Einschluss. Um so heißer das Plasma wird, um so schneller sich die Teilchen darin bewegen, um so schwieriger wird es das Plasma stabil einzuschließen. Aber zunächst stellte sich die Frage, wie ein Plasma überhaupt auf die nötigen Temperatuen bekommt.

Eine einfache Möglichkeit ein Plasma zu heizen, ist Strom. Ein Plasma besteht aus Ladungsträger und kann deswegen Strom leiten. Zwei Elektroden mit einer Spannung im Plasmabehälter können einen Strom fließen lassen. Die strömenden Ladungsträger übertragen dabei ihre Energie durch elektrostatische Kräfte auf den Rest des Plasmas. Der gleiche Strom hilft dabei, das Plasma einzuschließen, denn um jeden fließenden Strom herum bildet sich ein Magnetfeld.

Wenn zwei Ströme parallel fließen, dann entsteht eine Kraft zwischen beiden, die sie aufeinander zu bewegen lässt. Das ist äußerst praktisch, denn so schnürt sich ein Plasma von allein ein, wenn ein Strom durch fließt. Das alles passiert in einem beinahe-Vakuum, was bekanntlich ein guter Isolator ist. Wenn also nur genug Strom durch das Plasma fließt, dann sollte es sich aufheizen und von allein im freien Raum zu einem dichten Paket zusammen schnüren und dabei Kernfusion möglich machen. Das alles in einem kleinen Experiment, das auf eine Werkbank passt.

Die Anfangszeit: Die Physik macht nicht mit

In der Anfangszeit der 1950er Jahre schien das selbst mit kleinen Geräten eine lösbare Aufgabe zu sein. Ein Strom, der mit einer Spannung durch das Plasma getrieben wird, erzeugt ein eigenes Magnetfeld, durch das sich das Plasma selbst einschnürt. Aber es stellten sich bald Probleme mit diesen Pinch-Experimenten ein. Die Energieverluste waren um Größenordnungen höher, als vor den Versuchen vermutet worden war. Es wurden viel mehr Teilchen aus dem Plasma geschleudert als zuvor angenommen. Die Einschnürung funktionierte nicht so gut wie erhofft.

Der Grund waren Instabilitäten. Wo der Strom im Plasma nicht vollständig gerade verläuft, entsteht ein Anteil im Magnetfeld, der diesen Knick im Strom vergrößert. Bald darauf gab es Versuche, diese “Kink-Instabilität” auszugleichen. Es wurden Magnetfelder von außen benutzt, um das Plasma zu stabilisieren, anstatt sich nur auf das Magnetfeld zu verlassen, das vom Plasma selbst erzeugt wird.

Es wurden verschiedene Konzepte entwickelt, aber im Laufe der 50er und 60er Jahre wurde immer klarer, dass Fusionsexperimente auf der Werkbank keine brauchbaren Energiemengen freisetzen würden. Dadurch verschwand auch der Optimismus, dass schon in kurzer Zeit die ersten Fusionskraftwerke gebaut würden. Je größer die Anlagen sind, desto mehr Entwicklungszeit brauchen sie und desto länger dauert der gesamte Entwicklungsprozess.

Die Zähmung des Plasmas

Die erste große Aufgabe für die Forscher war es also, das Plasma in den Griff zu kriegen. Forscher in den USA und der Sowjetunion entwickelten in den 1950er Jahren, ohne voneinander zu wissen, dieselbe Lösung: das Konzept des magnetischen Spiegels. Dabei wird Plasma im Inneren einer magnetischen Spule erzeugt. Wegen der Lorentzkraft können sich die geladenen Teilchen im Plasma jetzt nur noch entlang der Magnetfeldlinien bewegen, alle Abweichungen führen nur dazu, dass sie sich auf Kreisbahnen um die Linien herum bewegen.

Auf diese Weise wird das Plasma stabilisiert. Am Ende der Spule wird das Magnetfeld noch einmal stark eingeschnürt, durch eine Spule mit kleinerem Durchmesser. An diesen Stellen wird das Magnetfeld deutlich stärker. Abweichungen in der Bewegungsrichtung von den Feldlinien sind dann in Richtung des stärkeren Magnetfelds mit größeren Kräften verbunden als umgekehrt. Im Resultat werden die Plasmateilchen wieder zurückgedrängt.

Diese magnetischen Spiegel sind aber nicht perfekt. Teilchen, die sich mit viel Energie zufällig genau entlang der Magnetfeldlinien bewegen, können dem Magnetfeld trotzdem entkommen.

Die richtige Lösung für das falsche Problem

Das ist schlecht für die Kernfusion, in der gerade die energiereichen Teilchen im Magnetfeld bleiben sollen. Es ist aber perfekt für elektrische Plasmatriebwerke, bei denen die energiereichen Teilchen ausgestoßen werden sollen. Satelliten und Raumsonden brauchen mit solchen Triebwerken nur noch einen Bruchteil des Treibstoffs für ihre Manöver im Weltraum. Die Forschung war also nicht vergebens, brachte aber der Kernfusion keinen Durchbruch.

Der letzte Versuch, das Konzept doch noch für die Kernfusion weiterzuentwickeln, scheiterte an den Finanzen. Motiviert durch die Ölkrise unternahmen die USA nochmals große Anstrengungen und eröffneten 1977 das Tandem Mirror Experiment – nach Investitionen von geschätzten 11 Millionen US-Dollar (inflationsbereinigt 44 Millionen Dollar heute).

Daraus entstand die Mirror Fusion Test Facility, ein Reaktor nach dem Konzept des magnetischen Spiegels. Er wurde am 21. Februar 1986 nach neun Jahren Bauzeit und 372 Millionen US-Dollar (inflationsbereinigt etwa 835 Millionen US-Dollar) Baukosten eröffnet. Aber noch am gleichen Tag wurden dem Projekt von der Reagen-Regierung alle Mittel für die dann anstehende Forschungsarbeit gestrichen, angeblich wegen Problemen im Budget des Bundeshaushalts der USA. Der Reaktor ging nie in Betrieb. Das Prinzip wurde kaum noch weiterverfolgt, auch wenn einige Entwicklungen wie der kompakte Fusionsreaktor, den Lockheed-Martin entwickeln will, eine ähnliche Technik verwenden.

Das erste Konzept, das die nötige Temperatur erreicht

Erfolgreicher war ein anderes Konzept zur Zähmung des Plasmas: der Tokamak. Auch bei diesem Konzept befindet sich das Plasma in einer magnetischen Spule, die aber zu einem Donut gebogen wird. Dadurch entsteht zunächst ein kreisförmiges Magnetfeld, die Verluste eines durchlässigen Spiegels werden vermieden.

Das Magnetfeld dieser Spule wird nun durch ein zweites Magnetfeld überlagert, dessen Magnetfeldlinien senkrecht dazu stehen. Es übt eine zusätzliche Kraft aus, die das Plasma in die ringförmige Bahn zwingt. Zusätzlich zu all dem wird jetzt das Plasma in Bewegung versetzt. Es fließt also ein ringförmiger Strom, wie wir ihn schon vom Pinch kennen. Dieser Strom hilft auch mit, das heiße Plasma von den Wänden des Reaktors fernzuhalten und so Energieverluste zu vermeiden.

Die erste Idee dafür hatte der Physiker Oleg Lawrentiew schon 1950 in der Sowjetunion. 1968 versetzte das Konzept die Welt in Erstaunen, als es als erstes Reaktorkonzept die nötigen Temperaturen für eine kontrollierte Kernfusion erreichte.

Der Weg zum ersten Fusionsreaktor

Tokamaks waren der erste große Durchbruch auf dem Weg zur Kernfusion. 1968 erreichte ein Tokamak in der Sowjetunion schon Temperaturen über 1.000 Elektronenvolt – etwa 12 Millionen Kelvin. Nachdem die erste Ungläubigkeit überwunden war, wurden auch im Rest der Welt Tokamaks gebaut. Im Jahr der ersten Ölkrise, 1973, beschloss die Europäische Gemeinschaft schließlich den Bau eines gemeinsamen, großen Tokamaks.

Der Joint European Torus (Jet) ist bis heute der größte Fusionsreaktor der Welt. Er wurde noch mit der Technik der 1970er Jahre gebaut, lange vor der Entdeckung moderner Supraleiter. Seine Kupferspulen erreichen Magnetfelder mit einer Stärke von 3,5 Tesla.

Eröffnet wurde Jet 1983, er hält bis heute auch den Rekord in der kontrollierten Kernfusion. 1997 gab das Plasma eine Heizleistung von 40 MW ab. Davon stammten 24 MW aus der Heizung des Plasmas und 16 MW aus Kernfusion. Für eine wirtschaftliche Stromerzeugung müsste ein Reaktor aber etwa die zehnfache Menge der Heizleistung durch Fusion dauerhaft erzeugen. Das Plasma war – zumindest kurzzeitig – gezähmt, die nötige Temperatur erreichbar, die nächste Herausforderung war es, die Leistung zu erhöhen. Dafür mussten die Energieverluste in den Reaktoren weiter verringert werden. Einige Möglichkeiten dafür wurden im Laufe der Jahre gefunden und in dem aktuellen Projekt Iter umgesetzt.

Was Iter von Jet gelernt hat

Die einfachste Möglichkeit, Energieverluste zu verringern, ist die Vergrößerung des Reaktors. Je größer der Reaktor gebaut wird, desto kleiner ist die Oberfläche des Plasmas im Verhältnis zum Volumen. Da sich die Verluste hauptsächlich an der Plasmaoberfläche abspielen, ist das ein wichtiger Faktor. Ebenso wichtig ist die Stärke der Magnetfelder, die das Plasma einschließen und das Entweichen von Plasma verhindern.

Beim europäischen Projekt Iter wird diese Erkenntnis mit umgesetzt. Iter wird etwa doppelt so groß wie Jet sein und mit 14 Tesla die vierfache Magnetfeldstärke erreichen. Das Ziel ist, mit 50 MW Heizleistung dauerhaft 500 MW Fusionsleistung zu erreichen, also einen Q-Faktor 10. Zur Vorbereitung des Baus von Iter wurde das Innere des Torus von Jet inzwischen umgebaut und mit der gleichen Wandverkleidung ausgestattet, wie sie Iter haben soll. Denn es hatte sich gezeigt, dass die alten Graphitkacheln an der Wand des Reaktors zu viel Gas und andere Verunreinigungen aufnehmen und wieder an das Plasma abgeben.

Die neuen Wände aus Beryllium und Wolfram haben in Jet bereits jetzt ihre Fähigkeiten gezeigt. Bei Experimenten mit dem verbesserten Reaktor zeigte sich, dass das Plasma bei hoher Heizleistung nicht nur weniger Energie verliert als zuvor. In Versuchen mit den Graphitwänden stiegen die Verluste mit steigender Leistung überproportional an, mit den neuen Wänden ist dieses Verhalten verschwunden. Zusätzlich wird auch ein größerer Reaktor die Verunreinigungen reduzieren, weil sich bei Iter die Wandfläche im Vergleich zum Volumen auf etwa ein Zehntel des Werts von Jet reduziert.

Aber nicht nur die reine Hardware ist für die bessere Leistung verantwortlich.

Bessere Leistungen mit alter Hardware

Nicht nur die Hardware, sondern eine weitere Entdeckung an einem Tokamak-Projekt hat zu Verbesserungen in der Leistung der Reaktoren geführt. Am 4. Februar 1982 entdeckte der deutsche Physiker Fritz Wagner am deutschen Tokamak-Experiment Asdex die H-Mode, eine Plasmakonfiguration, bei der nur noch halb so viel Energie aus dem Plasma verloren geht wie sonst. Damit wurden in kleineren Tokamaks Plasmaentladungen demonstriert, die bei einem Reaktor wie Iter den angestrebten Q-Faktor 10 erreichen würden.

Diese H-Mode haben die Forscher mit den vorhandenen Messinstrumenten immer noch nicht vollständig theoretisch verstanden. Zurzeit ist sie “nur” eine empirische Tatsache, die sich in jedem Tokamak und auch in jedem Stellerator erzeugen lässt, der ausreichend Heizleistung bereitstellt und einen Divertor hat. Durch den Divertor und starke Vakuumpumpen wird Gas aus dem Plasma abgezogen und immer wieder im Tokamak recycelt. Im Laufe der vergangenen 34 Jahre hat sich auch die Erfahrung im Umgang mit der H-Mode verbessert. Dazu gehört auch der Umgang mit Elms (Edge Localized Modes).

Elms – nützlich bis zerstörerisch

Elms sind Ausbrüche von energiereichen Teilchen aus dem schwebenden Plasma, die im Zusammenhang mit der H-Mode auftreten. Zu starke Elms würden im Laufe der Zeit Material von der Reaktorwand abtragen und zu einem ernsthaften Haltbarkeitsproblem führen. Deswegen wird versucht, sie möglichst abzuschwächen, ohne sie ganz zu verhindern.

Denn Elms sorgen auch dafür, dass schwere Ionen aus dem Plasma getragen werden und es sauber halten. Das ist nötig, denn wenn Elektronen gegen schwere Ionen prallen, entsteht Röntgenstrahlung, durch die Energie aus dem Plasma verloren geht. Da der Einschluss des Plasmas nie perfekt ist, prallen immer wieder Atome gegen die Reaktorwand und schlagen einzelne Wolfram-Atome heraus, die dann das Plasma verunreinigen können, wenn sie nicht entfernt werden.

Dauerhafter Betrieb auch im Tokamak

Bisher ungelöst ist die Frage, wie das Plasma über längere Zeit stabil gehalten werden kann. Eins der Probleme des Tokamaks ist der ringförmige Strom, der durch den Torus getrieben wird. Anfänglich wurde er durch einen Transformatoreffekt erzeugt. Damit kann aber kein dauerhafter Strom in einer Richtung erzeugt werden. Deswegen konnte das Plasma zunächst bestenfalls für einige Sekunden stabilisiert werden.

Durch andere Techniken wie den Einschuss von Teilchen in den Torus von außen können Plasmaentladungen in Tokamaks mittlerweile immerhin für mehrere Minuten stabil gehalten werden. In Frankreich konnte der Tore Supra Tokamak Entladungen mit über 4 Minuten Dauer erreichen und vor kurzem erreichte auch der chinesische “EAST” eine Entladung von knapp 2 Minuten.

Ein anderer Ansatz zur Lösung dieses Problems ist der Stellerator, der durch die komplizierte Form seiner Magnetfeldspulen keinen induzierten Strom für ein stabiles Plasma nötig hat und es dauerhaft stabil halten kann. Für den praktischen Nachweis wurde zuletzt das Plasmaexperiment Wendelstein 7-X gebaut. Das ist auch nötig, denn die Praxis ist heute der wesentliche Flaschenhals in der Entwicklung.

Kernfusion bringt neue Unbekannte

Trotz aller Fortschritte: Energieverluste und die Stabilität des Plasmas sind bis heute die wichtigsten Probleme bei der Entwicklung eines funktionsfähigen Fusionskraftwerks. Die nächste Herausforderung wird der Betrieb mit einem größeren Anteil von Kernfusion an der Heizleistung des Plasmas sein. In den meisten Versuchen heute stammt praktisch die gesamte Heizleistung des Plasmas aus Wärmequellen von außen. Geheizt wird das Plasma in den derzeitigen Reaktoren durch eine Kombination verschiedener Quellen. Eine Möglichkeit ist der elektrische Widerstand im Plasma. Wie in einem normalen elektrischen Leiter entsteht auch dort Wärme durch fließenden Strom.

Allerdings nimmt der Widerstand im Plasma bei sehr hohen Temperaturen wieder ab, wodurch die damit erreichbare Temperatur begrenzt ist. Weitere Möglichkeiten sind Radio- und Mikrowellen, die mit den Ionen und Elektronen des Plasmas interagieren. Genauso trägt auch der Einschuss neutraler Teilchen zur Heizung bei, mit der in den Tokamaks auch der Strom getrieben werden soll.

In einem realen Fusionskraftwerk wird hauptsächlich die Kernfusion selbst die Heizung übernehmen. Wie genau sich das auswirkt, lässt sich aber nicht bis ins letzte Detail vorhersagen. Die Energieverluste des Plasmas werden zwar immer besser verstanden, aber zumindest müssen die theoretischen Berechnungen auch in der Praxis überprüft werden. Dafür braucht es Experimente. Die nächsten werden 2017 stattfinden, wenn zum ersten Mal nach 20 Jahren Pause wieder eine Kernfusionskampagne mit Tritium und Deuterium im verbesserten Joint European Torus durchgeführt wird.

Außerdem muss noch die Erbrütung von Tritium im Fusionsreaktor umgesetzt werden. Tritium soll dort durch Bestrahlung von Lithium mit Neutronen erzeugt werden. Bei jeder Fusion von Deuterium und Tritium wird ein schnelles Neutron frei, das für diesen Zweck zur Verfügung stehen wird. Damit dabei genug Tritium erzeugt werden kann, wird sich nicht nur Lithium, sondern auch Blei in dem Brutmantel befinden. Wenn die schnellen Neutronen auf Bleiatome treffen, können sie ein zusätzliches Neutron aus dem Kern reißen. So stehen insgesamt genug Neutronen für die Tritiumerzeugung zur Verfügung, ohne dass radioaktive Spaltprodukte anfallen würden.

Niemand weiß, wann das erste Fusionskraftwerk gebaut wird

Wann genau es so weit ist und alle Erkenntnisse in einem Fusionskraftwerk zusammengesetzt werden, kann niemand sagen. Die Vergangenheit hat gezeigt, dass Forschungsbudgets selten stabil sind. Durch die Anstrengungen der Chinesen in der Entwicklung der Kernfusion ist die Entwicklung aber nicht mehr vollständig von einzelnen Projekten wie Iter abhängig.

Der erste chinesische Tokamak war der Asdex-Reaktor. Der Reaktor, an dem Fritz Wagner den H-Modus entdeckte, wurde nach China gebracht und dort als HL-2A wieder aufgebaut. Seit 2006 ist auch EAST in Betrieb, der Experimental Advanced Superconducting Tokamak. Während China auch einen Teil zum Iter-Programm beiträgt, wird dort schon der Bau eines weiteren, größeren Reaktors in den 2020er Jahren geplant. Der “China Fusion Engineering Test Reactor” soll zwar kleiner als Iter sein, wird aber vollständig in China gebaut werden und soll die Grundlage für ein chinesisches Demonstrationskraftwerk in den 2030er Jahren legen.

Finanzierung und Politik

Auch für diese Entwicklung gelten die üblichen Unwägbarkeiten. Die chinesische Politik gilt zwar als sehr langfristig im Vergleich zu europäischen und amerikanischen Verhältnissen, aber auch chinesische Forschungsgelder können gestrichen werden. Das ist inzwischen zur wesentlichen Frage geworden. Die Frage, ob der Bau eines Fusionskraftwerks möglich ist, ist geklärt. Nicht geklärt ist nur, ob und wann der Bau umgesetzt wird.

Historisch gesehen sind die technischen Probleme wesentlich leichter lösbar als die finanziellen und politischen Probleme, wie man bei der Mirror Fusion Test Facility sieht. Man sieht es auch darin, dass der leistungsfähigste Fusionsreaktor der Welt auf inzwischen 40 Jahre alter Technik basiert. Wie groß genau die Kosten von Gemeinschaftsprojekten wie ITER sind, ist dagegen schwer zu ermitteln. Die offiziellen Zahlen sind im wesentlichen Schätzungen.

Die Beiträge der einzelnen Länder werden in “Naturalien” geleistet. Die Mitglieder zahlen keine Geldbeträge, die dann einer Projektleitung als Budget zur Verfügung stünden. Das hat den Vorteil, dass ein Teil des Know-Hows und der industriellen Basis zur Herstellung dieser Komponenten anschließend in vielen Ländern zur Verfügung steht und nicht nur in einem. Es hat auch den diplomatischen Vorteil, dass mehrere Länder darin kooperieren. Gleichzeitig ist es ein organisatorischer Alptraum. Die Koordination ist schwierig und Probleme sind unvermeidlich. Es kommt nicht nur wegen der Koordinationsprobleme zu Verzögerungen. Es wird auch viel unnötiger Aufwand getrieben, weil identische Komponenten in mehreren Ländern gebaut werden.

Als Grund für diesen verteilten Ansatz werden oft die hohen Kosten angeführt, die von einem einzigen Land getragen werden müssten. Die Kosten sind in der Tat recht hoch. Letzte Schätzungen gingen von etwa 15 Millarden Euro aus. Bei einer Projektlaufzeit von 30 Jahren bedeutet das Ausgaben von etwa 500 Millionen Euro pro Jahr. Das entspricht in etwa den Ausgaben die 2015 für die EEG-Umlage in Deutschland alle 9 Tage anfielen und selbst diese Kosten werden noch auf alle Teilnehmerländer verteilt.

Die Alternative ist ein zentral organisierter Ansatz, wie er in China verfolgt wird. Während China auch einen Teil zum ITER Programm beiträgt, wird dort gleichzeitig ein eigenes, unabhängiges Programm verfolgt. Wann genau die Kernfusion als Energiequelle umgesetzt werden kann, ist eine Frage, die kaum beantwortet werden kann. Sie benötigt Reaktoren einer bestimmten Größe und einer bestimmte Stärke von Magnetfeldern, die keiner der jahrzehnte alten Reaktoren aufweist. Auch Wendelstein 7-X wurde als reines Plasmaexperiment entworfen und wird keine Kernfusion in nennenswertem Umfang betreiben. Möglicherweise können einige Projekte von Privatfirmen wie TriAlpha Fortschritte erzielen, aber derzeit sind sie selbst von der Leistung der Tokamaks der 70er Jahre noch weit entfernt. Die Entwicklung der Kernfusion ist keine Frage der Zeit, sondern eine Frage des Entschlusses für den Bau der nötigen Anlagen.

Kommentare (8)