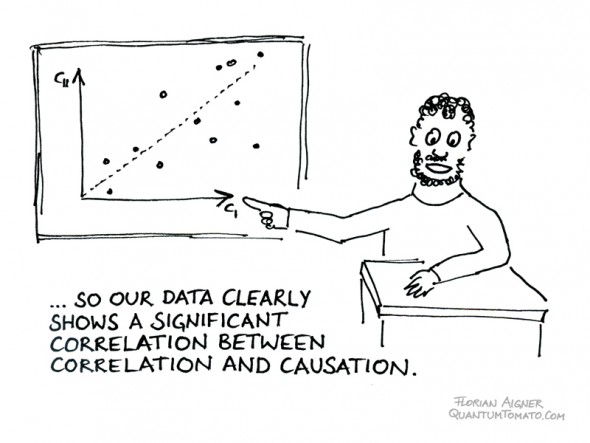

Zusammenhänge erfinden und so lange messen, bis irgendetwas statistisch signifikant wird, ist keine Wissenschaft.

Angenommen, ich möchte die heilende Kraft der Gedankenübertragung erforschen. Aus einer Gruppe von hundert Personen wähle ich fünfzig aus, denen ich dann einmal täglich, in einem Zustand tiefspiritueller Konzentration, positive Geistesenergie sende. Und nehmen wir an, nach vier Monaten stellt sich heraus, dass diese fünfzig Leute signifikant gesünder sind als die anderen fünfzig, denen ich keine Gedankenenergie gesendet habe. Beweist das dann die Wirksamkeit meiner Methode?

Nein, natürlich nicht: „Correlation does not imply causation.” Aber leider kommt es ziemlich oft vor, dass genau diese Herangehensweise, das bloße Suchen nach statistischen Zusammenhängen, ohne erkennbaren kausalen Zusammenhang, als Wissenschaft präsentiert wird.

Bei der Theorie über die heilende Gedankenübertragung ist die Sache ziemlich klar: Es gibt keinen bekannten Mechanismus, über den meine Gedanken den Gesundheitszustand anderer Leute beeinflussen könnten. Würde man solche Effekte finden, würde das wohl mehr Fragen aufwerfen als beantworten: Man müsste untersuchen, welche Eigenschaften diese mysteriöse geistige Energie hat, wie sie zum Energieerhaltungssatz passt, ob im Sinn der Informationstheorie Information übertragen wird, ob es sich um eine neuartige Strahlung handelt, die einem Abstandsgesetz gehorcht.

Es fällt schwer, sich vorzustellen, wie eine bisher unentdeckte Gedankenkraft beschaffen sein könnte, ohne in sich unlogisch und widersprüchlich zu sein, oder gegen die bekannten Naturgesetze zu verstoßen. Wenn wir einen statistisch signifikanten Effekt des Gedankenheilens finden, würden wir daher zunächst wohl vermuten, dass dieser Effekt durch bloßen Zufall zustande gekommen ist.

Szientabilität

Das erinnert an das Konzept der „Scientabilität“, das der Biologe und Wissenschaftsjournalist Christian Weymayr verwendet, um seine Bedenken gegenüber der Homöopathie zu erklären: Wissenschaftliche Untersuchungen homöopathischer Präparate, etwa Doppelblindstudien, sind nur bedingt sinnvoll, meint Weymayr. Die Aussagen der Homöopathie passen nicht zu den anerkannten Naturgesetzen, sie sind teilweise sogar in sich widersprüchlich, daher ist die Homöopathie nicht „scientabel“ – sie kann sich nicht in den großen Rest der Naturwissenschaft einfügen, von dem wir sehr genau wissen, dass er stimmt.

Ob man das Konzept der Homöopathie damit vom Tisch fegen kann, ob es sinnvoll ist, mit diesem Argument künftige wissenschaftliche Untersuchungen für sinnlos zu erklären, ist Geschmacksfrage. Aber die Grundidee dahinter ist wichtig: In der Wissenschaft genügt es nicht, irgendwelche Zusammenhänge zu suchen und „Heureka“ zu schreien, wenn man etwas statistisch Signifikantes gefunden hat. Man muss immer auch überlegen, wie die neue Erkenntnis – falls es denn wirklich eine ist – auf rational-wissenschaftliche Weise erklärt werden kann.

Bad Science: Signifikante Ergebnisse – für den Papierkorb

Wenn skeptische, wissenschaftlich denkende Menschen dieses Argument verwenden, um esoterischen Unfug zu entlarven, dann muss man allerdings ähnlich restriktive Maßstäbe auch an die echte Wissenschaft anlegen. Und da müssen wir ganz offen zugeben: Auch das, was von echten Wissenschaftlern mit ordentlichem Diplom an richtigen Universitäten produziert wird, wird solchen hohen Ansprüchen nicht immer gerecht. Das ist schade. Viel zu oft liest man von angeblich aufgedeckten Zusammenhängen, ohne dass ein kausaler Grund dafür erkennbar wäre.

So gibt es etwa eine ständig wachsende Zahl von Studien, die Lebensmittel mit Krebs in Verbindung bringen. Rotwein, Tomaten, Kaffee, rotes Fleisch – man findet Studien, die mit statistisch signifikanten Daten belegen, dass all diese Nahrungsmittel das Krebsrisiko fördern. Und dann findet man andere Studien, die von denselben Nahrungsmitteln behaupten, das Krebsrisiko zu mindern. Das bedeutet nicht, dass irgendjemand Daten manipuliert oder erfunden hat, das passiert nun einmal, wenn man nicht nach klaren Kausalketten sucht, sondern sich mit statistischen Korrelationen zufriedengibt.

Einen ähnlichen Fehler begeht man, wenn man nach Korrelationen zwischen Genen und menschlichem Verhalten sucht: Ein kausaler Zusammenhang ist kaum zu finden, dafür ist das System einfach zu komplex. Aber wenn man irgendwelche statistischen Korrelationen findet, kann man ein Paper darüber schreiben, und die Boulevardpresse verkündet dann begeistert die Entdeckung des „Mörder-Gens“, oder ähnlichen Unfug.

Auch wenn Psychologen Fragebögen austeilen und dann nach Korrelationen suchen, passiert oft Ähnliches: Wahlweise wird eine Affinität zu Videospielen mit mehr Gewaltbereitschaft, bösartigerem Verhalten im Straßenverkehr oder auch mit höherer Intelligenz in Verbindung gebracht. Man kann eine Studie über Religiosität und Empathie austeilen und dann behaupten, Ähnlichkeiten zwischen Psychopathen und Atheisten gefunden zu haben. Schön. Und was sagt uns das jetzt?

Erst die Theorie, dann das Datamining

Der Fehler ist immer derselbe: Es geht hier nicht um ein Modell, das einen Aspekt der Welt wirklich erklärt – zumindest nicht um ein ernstzunehmendes Modell, das zum Rest unseres Wissens passt. Die Frage nach Ursache und Wirkung, nach verständlichen Kausalketten, die ein entscheidendes Element der Wissenschaft ist, wird ausgeklammert, zufällig aufgetretene oder durch passende Auswahl der Fragen mutwillig provozierte Zusammenhänge werden aber trotzdem als Erkenntnisgewinn verkauft.

Die Wissenschaft muss kausale Zusammenhänge suchen und echte Erklärungen finden. Eine statistische Korrelation ohne darunterliegende solide Theorie ist noch keine Wissenschaft. Das bedeutet nicht, dass bloßes Sammeln und Auswerten von Daten nicht als erster Schritt eine gute Sache sein kann. Aber wir sollten solche Ergebnisse mit Vorsicht betrachten. Und keinesfalls sollten wir sie zum Anlass für großes Mediengeschrei verwenden. Es gibt ausreichend viel gute, saubere, verlässliche Wissenschaft, die sich für Schlagzeilen eignet.

Kommentare (44)