Primaklima will es besser machen als der ganz gewöhnliche Wissenschaftsjournalismus. Soviel Anspruch muss schon sein. Woran nämlich krankt dieser? Fehlende Konstanz!

Der Economist hatte vor einiger Zeit einen schönen Artikel dazu, wie und wieso Journalisten ein wissenschaftliches Thema aufgreifen und wieso sie dann leider nie dran bleiben. Das Auswählen ist dabei völlig ok, man muss immer auswählen und es liegt auf der Hand mit den sexy Themen anzufangen. Das Nicht-dran-bleiben aber hat Gründe, die mit einer gewissen Inkompatibilität von Medien und Wissenschaft zu tun haben. Denn natürlich wird in der Wissenschaft immer erstmal viel ausprobiert und vorgeschlagen. Erst nach der Veröffentlichung einer Hypothese, und gerade einer interessanten, überraschenden Hypothese, beginnt die eigentliche Arbeit: Kann das Resultat mit anderen Methoden nachvollzogen werden? Ist die Interpretation mit anderen Theorien zu vereinbaren? Wie sensitiv ist das Resultat gegen Änderung einiger nicht so ganz eindeutiger Eingangsparameter? Alles deutlich weniger sexy als die ursprüngliche These, klar. Sollte dann ein einst grosz besprochenes Resultat mal nicht diesen wissenschaftlichen Prozess überleben, erfährt man leider nie etwas davon. Es ist nicht der Konflikt von “Hund beisst Mann” vs. “Mann beisst Hund”; es ist sogar noch schlimmer: Es ist der Konflikt zwischen “Mann beisst Hund” vs. “Mann hat Hund dann doch nicht gebissen”.

So berichtete die FAZ vor kurzem unter anderem von den Resultaten eines Science Papers von Schmittner et al. , demzufolge die Klimasensitivität sich vielleicht doch eher am unteren Rand der Abschätzungen des IPCC befinden könnte. Die übliche Schnappatmung der Skeptiker angesichts solch eines Artikels braucht natürlich gar nicht erst erwähnt zu werden (hier ). Aber wer blieb am Thema dran? Konnte die Wissenschaftsgemeinde überzeugt werden? Konnten die Resultate anders bestätigt werden?

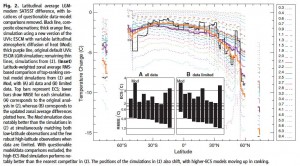

Simulierte Temperaturänderungen zwischen dem letzten glazialen Maximum und dem heutigen Klima. Jede Simulation wird bewertet relativ zu einem Paleodatensatz; dabei ist der Datensatz der ursprüngliche Datensatz A der aus dem Schmittner et al. Paper und B ein leicht verkleinerter Datensatz. Diese Verkleinerung versuchte bestimmte Innonsistenzen zu korrigieren. Tatsächlich hat die Änderung einen deutlichen Einfluss auf die Performance der Simulationen. Die Modellversion “Mod” schneidet in Datensatz B deutlich besser ab. Seine Klimasensitivität liegt bei 3.5°C.

Kurz zur Idee des Schmittner Papers. Die Physik der Klimamodellen wird von einer ganzen Reihe von Parametern kontrolliert, deren Wert wir nicht genau kennen. Innerhalb der Grenzen unseres Wissen oder Unwissens dieser Parameter produzieren die Modelle recht unterschiedliche zukünftige Klimaverläufe. Die Maszzahl für diese unterschiedlichen Verläufe wird häufig die Klimasensitivität angegeben: ECSX2CO2=Equilibrium climate sensitivity bei 2*CO2. ECSX2CO2 liegt bei den meisten Modellen in ihrer jeweiligen Parameterisierung zwischen 2-4°C. Spielt man aber kräftig mit solchen Parametern wie der Ozeandiffusivität oder einigen Wolkenparametern so kann man leicht zwischen 1-6°C für die ECSX2CO2 landen.

Wie kann man diesen Bereich einschränken? Schmittner et al. benutzen ein sehr schnell zu rechnendes und daher sehr einfaches Klimamodell unter den Randbedingungen des letzten glazialen Maximums. Bei jeder der 47 Modellrechnungen variieren sie einen oder mehrere Parameter, berechnen die jeweilige Klimasensitivität ECSX2CO2 und vergleichen das jeweilige Resultat mit der Güte der Übereinstimmung mit den glazialen Temperaturrekonstruktionen, von denen es mehr und mehr gibt und die mittlerweile schon ein recht dichtes Netz hergeben. Ohne die Details weiter zu erläutern, kann man sich schon vorstellen, dass man prima eine Statistik betreiben kann, die dann die wahrscheinlichste Klimasensitivität und einen dazzu gehörenden Wahrscheinlichkeitsbereich ausrechnet. Der Median Wert der ECSX2CO2 war dabei 2.3°C mit einem 66% Bereich von 1.7-2.6°C. Insbesondere der kleine Unsicherheitsbereich überrascht natürlich. Die Werte an sich, sind nicht unbedint eine Überraschung, wenn auch die 2.3°C am unteren Bereich der IPCC Werte liegen.

Das Paper wurde nun für eine ganze Reihe von Dingen kritisiert, die ich hier nur kurz aufliste: (1) Problem mit der Statistik , (2) fehlende Modellfeedbacks, insbesondere Wolken, (3) gute Übereinstimmung mit den Ozeandaten, aber lausige Übereinstimmung bei den Landdaten . Letzeres finde ich besonders eigenartig, will aber nicht weiter auf die Dinge eingehen. Die Diskussion unter anderem mit den Autoren auf Realclimate war interessant und ziemlich animiert. Wer meint, dass sich Wissenschaftler immer nur lieb auf die Schulter klopfen, mag dort mal reinlesen.

Es gab aber vor kurzem im September noch einen formellen Kommentar von Jeremy Fyke und Michael Eby. Sie haben genau die gleiche Modell/Daten Konfiguration genommen und sich einige Sachen nochmal genauer angeschaut. So befanden sie, dass einige Daten in der Nähe der Eisschilde nicht genommen berücksichtigt sollten, da im Modell an der jeweiligen Stelle Eis simuliert wurde, während aber die Daten auf Polleninformationen beruhten. Auch an einigen weiteren Daten in der nördlichen Hemisphäre hatten sie etwas auszusetzen und nahmen sie aus dem Daten/Modell-Vergleich heraus. Obwohl es sich um eine relative kleine, geographisch eingegrenzte Untermenge der verfügbaren Paleodaten handelt, ist die Wirkung des Wegstreichens dieser Daten erheblich. Fyke/Eby nahmen noch eine leicht geänderte Version desselben Klimamodells und führten eine ähnliche Rechnung wie Schmittner et al. durch. Jetzt lag diese Modellversion mit ihrer Klimasensitivität von ca. 3.5°C vorne. Das ganze Verfahren erscheint also relativ sensibel und vor allem der sehr enge Unsicherheitsbereich scheint doch sehr zweifelhaft. Fyke/Ebys Modellversion wäre, soweit ich das sehe, ausserhalb des 95% Bereichs des ursprünglichen Papers.

Die Antwort der Autoren des Originalpapers findet sich hier und fällt gemischt aus. Teils Zustimmung, teils Ablehnung. Es werden mit Sicherheit noch weitere Modelle mit einem ähnlichen Ansatz auf die stetig wachsende Menge an Daten aus dem letzten glazialen Maximum losgelassen werden (hier zb). Primaklima bleibt natürlich bei diesem Thema am Ball.

Kommentare (10)