Ich wollte schon seit langem versuchen, Interviews mit Klimaforschern zu führen und dann hier zu veröffentlichen. Es sollen da die vermeintlich großen Fragen des Klimageschäfts behandelt werden, aber auch gefragt werden, wie denn der eine oder andere überhaupt dazu gekommen ist, zu diesem Thema zu arbeiten. Man mag es nämlich kaum glauben, aber als ich angefangen habe, war das Thema Klima noch längst nicht so en vogue wie heute und und als mein erster Interviewpartner, Dr. Martin Heimann, damit anfing erst recht nicht. Martin Heimann ist Schweizer und arbeitet seit einiger Zeit aber am MPI für Biogeochemie in Jena als Chef der Arbeitsgruppe Biogeochemische Systeme. Er ist contributing und lead author von mehreren IPCC Berichten (ich glaube alle, die ich kenne). Ach ja, und vor langer Zeit hatte er einen Doktoranden namens Georg Hoffmann.

Bild: Prof.Dr.Martin Heimann irgendwo in Sibirien bei der Erstellung der Kohlenstoffbilanz von Taiga und Tundra. © MPI für Biogeochemie

Guten Tag Martin.

1) Was ist deine momentane Tätigkeit?

Ich schreibe diese Zeilen im Allegro-Zug von St. Petersburg nach Helsinki; komme zurück von einem kleinen Workshop über Methanemissionen aus Permafrostregionen. Zur Zeit bin ich Gastprofessor am physikalischen Institut der Uni Helsinki und leite aber nach wie vor die Abteilung „Biogeochemische Systeme“ am Max-Planck-Institut für Biogeochemie in Jena.

2) Wie bist du eigentllich zum Thema Erforschung des Kohlenstoffkreislauf gekommen?

Ich habe in den 1970’er Jahren an der Uni Bern in der Schweiz Physik studiert. Obwohl ich mich zuerst für die Theorie interessierte, wurde ich aufmerksam auf die Arbeitsgruppe von Hans Oeschger und Uli Siegenthaler, die sich mit der Erforschung des Kohlenstoffkreislaufs befassten. Im Rückblick würde man dies heute wohl schon mit „Erdsystemforschung“ bezeichnen. Oeschger hatte einen neuen, besseren Zähler für die Messung von Radiokohlenstoff (14C) entwickelt und nutzte eine Batterie dieser Zähler in einem extra dafür gebauten „Tiefenlabor“, einem etwa 30m tief unter dem Institut gelegenen Keller, um alle möglichen Substanzen zu datieren. Der Keller sollte dabei die kosmische Strahlung reduzieren, zudem wurde ein Uran-armer Spezialbeton verwendet um möglichst wenig falsche Impulse im Zähler zu registrieren. Um den Effekt der verschiedenen Abschirmungen zu bestimmen, brauchten sie einen Rechenknecht, der sich mit Numerik und Programmierung des damaligen IBM-360 Universitätsrechners auskannte. Ergo I.

Um die Radiokohlenstoffmessungen in den unterschiedlichsten Medien über die reine Datierung hinaus zu interpretieren, interessierte sich die Oeschger-Gruppe für den globalen Kohlenstoff und dessen Veränderungen durch das Klima und den Menschen. Änderungen der Produktion des natürlichen 14C aber auch das durch die Atomwaffentests erzeugte 14C wiederspiegeln sich unterschiedlich in den verschiedenen Kohlenstoffreservoiren der Erde. Aus diesen Unterschieden lässt sich sehr viel über die Transferraten und Umwälzzeiten im Kohlenstoffkreislauf lernen. Die Berner Gruppe entwickelte hierzu ein globales, recht simples, aber auch heute noch aktuelles Kohlenstoffmodell (das sogenannte Box-Diffusion-Model), dessen Modellparameter durch 14C-Beobachtungen kalibriert wurden, und welches die globale Dynamik des Kohlenstoffkreislaufs eigentlich recht realistisch wiedergibt. Auch hier wurde ein Rechenknecht gesucht, der u.a. das stabile Isotop 13C in das Modell einzubauen hatte. Ergo II.

Ein dritter Grund ergab sich aus der damals faszinierenden Hoffnung, aus Eiskernen durch hochpräzise Analysen der Gaskonzentrationen in den Eisbläschen die Geschichte der Zusammensetzung der Atmosphäre in der Vergangenheit zu rekonstruieren. War technische eine enorme Herausforderung und es dauerte etwa 10 Jahre bis erste glaubwürdige Resultate etwa um 1984 publiziert werden konnten. Allein schon die Aussicht als Student möglicherweise nach Grönland oder sogar in die Antarktis zur Feldarbeit mitgenommen zu werden hatte was, auch wenn es dann nur zu einigen Messkampagnen auf Alpengletschern und mit Schweizer Militärflugzeugen reichte.

Nach meinem Diplom kam Dave Keeling, der Vater der Mauna Loa Kurve, zu uns nach Bern für ein Gastsemester mit einem tollen Projektthema. Es ging dabei um die Interpretation einer seiner atmosphärischen Messkampagnen mit Hilfe von einem Modell des atmosphärischen Transports. Daraus wurden dann zwei Paper in meiner Diss und danach eine Stelle als Postdoc am Scripps Institution of Oceanography in La Jolla in Kalifornien.

3) Zwei Frage zur globalen Verteilung der CO2 Emissionen. Es herrscht mittlerweile weitestgehend Einigkeit darüber, dass von den anthropogenen Emissionen ca 30% vom Ozean absorbiert werden, 30% in die terrestrische Biosphäre und die restlichen 40% in die Atmosphäre gehen. Lange Zeit sprach man aber von einer missing sink von ca 20% des totalen Budgets.

A) Was ist passiert, dass man meint, das Budget sei jetzt besser im Griff?

Der Begriff „missing sink“ stammt aus den 1960ern und frühen 1970ern, als man nur die fossilen Emissionen (Verfeuerung von Kohle, Öl und Gas) aufsummierte und dem Atmosphärenzuwachs und der Ozeanaufnahme (berechnet mit Hilfe der 14C Methode, wie oben aufgezeigt) gegenüber stellte. Ein allfälliges, meistens sehr kleines Residuum, wurde als „missing sink“ bezeichnet. In 1978 schlug dann ein Paper in Science von Woodwell und Kollegen wie eine Bombe ein: Sie hatten erkannt, dass durch Änderungen der Landnutzung, vor allem den Brandrodungen durch den Menschen, beträchtliche weitere Mengen CO2 freigesetzt werden. Woodwell et al.’s Schätzungen gingen dabei bis zu 18 PgC/Jahr! (zum Vergleich: In 2012 betrugen die gesamten anthropogenen Emissionen etwa 9.7 PgC/Jahr). Damit mussten neue Senken her, um die globale CO2 Bilanz zu schliessen. Viele Kohlenstoffkreislauf-“Experten“ wandten sich nun auch der Landbiosphäre zu und eine Vielzahl von Ökologen begannen sich nun auch für den Kohlenstoffkreislauf zu interessieren. Die zentrale Frage lautete damals und auch heute noch: welcher Prozess steckt denn hinter der nun beträchtlichen „missing sink“? Aus einer Vielzahl von Untersuchungen, deren Aufzählung hier den Rahmen sprengen würde, wissen wir, dass die „missing sink“ oder „unidentified sink“ in der Landbiosphäre zu suchen ist. Daher wird sie nicht mehr so benannt. Bei der quantitativen Berechnung der Bilanz ist es allerdings nach wie vor so, dass man den Emissionen die Zunahme in der Atmosphäre und die inzwischen sehr genau bekannte Ozeanaufnahme entgegenstellt und das Residuum der Landbiosphäre zuordnet.

B) Es gibt ja Arbeiten, die sagen, dass der Anteil des CO2, der in der Atmosphäre bleibt, über längere Zeitskalen (100 Jahre) relativ konstant ist (Airborne Fraction). Mit anderen Worten, ist die obige Aufteilung von 30:30:40 wirklich so stabil, wo doch anscheinend über die letzten 100 Jahren so viel passiert ist (wärmere Ozeanoberfläche, Waldnutzung, Landwirtschaft, etc)? Verstehen die Modelle die Gründe für diese Konstanz?

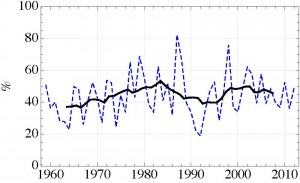

Die nahezu-Konstanz der „Airborne Fraction“ (AF) ist in der Tat auf den ersten Blick erstaunlich. Man muss allerdings die Daten über 10 Jahre mitteln; von Jahr zu Jahr gibt es schon erhebliche Veränderungen, die auf Klimaeffekte (u.a. El Nino) zurückgeführt werden können. Zudem ist fest zu halten, dass der aus Beobachtungen ermittelte Wert der AF beträchtliche Unsicherheiten aufweist, da die Emissionen aus den Änderungen der Landnutzung grosse Unsicherheiten aufweisen. Im neusten IPCC Bericht geben wir in Kapitel 6 den Wert der AF mit 0.44 ± 0.06 an, berechnet über den Zeitraum 1960-2010. In diesen Unsicherheiten könnte sich natürlich ein Trend verbergen, der jedoch zur Zeit statistisch nicht signifikant ermittelt werden kann.

Die Abbildung zeigt die AF berechnet aus den publizierten Daten des „Global Carbon Projects“. Die gestrichelte Linie bezeichnet die jährlichen Werte; die ausgezogene schwarze Linie stellt das gleitende 10-Jahresmittel dar.

Abbildung: Welcher Anteil des vom Menschen emittierten CO2 bleibt eigentlich in der Atmosphäre “hängen”. Die “Airborne fraction” variiert zwar stark, ist aber im langzeitlichen Mittel erstaunlich konstant bei ca. 44±6% und das, obwohl in den 150 Jahren stets anwachsender anthropogener Emissionen doch so viel mit dem Klima und den natürlichen Kohlenstoffsenken und Quellen passiert ist.

Warum ist die AF aber auf dekadaler und längerer Skala nahezu konstant? Als Physiker kann man dies recht gut verstehen, wenn man bedenkt, dass der globale Kohlenstoffkreislauf im wesentlichen ein System von Reservoiren unterschiedlicher Grösse und Umwälzraten ist, welche untereinander durch Transferprozesse verknüpft sind. Regt man ein solches System durch eine kleine Störung an, so kann man es mit einem Differentialgleichungssystem erster Ordnung beschreiben. Mathematisch entspricht dies einer Taylor-Entwicklung der u.U. sehr komplexen Austauschflüsse um einen Basiszustand. Wenn man sich den zeitlichen Verlauf der CO2 Emissionen ansieht, dann erkennt man, dass dieser nahezu exponentiell verläuft. Facht man ein solches Differentialgleichungssystem mit einer exponentiellen Störung an, dann ist leicht einzusehen, dass sich alle Inhalte der Reservoire und alle Austauschflüsse exponentiell mit derselben Zeitkonstante verändern. Und die Verhältnisse zwischen irgend zwei Variablen in diesem System sind konstant. Ergo ist auch die AF konstant.

Natürlich ist die Wirklichkeit komplexer, aber ich glaube dass dies der Effekt erster Ordnung ist, und dass sich die anthropogene Störung des Kohlenstoffkreislaufs daher noch weitgehend im linearen Bereich bewegt. Offensichtlich wirken sich alle nichtlinearen Effekte auf globaler Skala noch nicht messbar aus (auch wenn dies in der Literatur manchmal anders behauptet wird).

In gekoppelten Kohlenstoffkreislauf-Klimamodellen kann man dies nachrechnen. Alle Modelle zeigen längerfristig einen positiven Trend, d.h. dass Ozean und Land mit weiterhin zunehmenden Emissionen relativ weniger CO2 aufnehmen. Der Trend ist allerdings recht gering und dürfte sich, je nach angenommenem Emissionsszenarium, erst gegen Mitte dieses Jahrhunderts in den Beobachtungen abzeichnen. Für Details dazu siehe auch das Paper von Manuel Gloor, Jorge Sarmiento und Nicolas Gruber.

4) Für jede Art von Klimaverhandlungen, möchte man die CO2 Flüsse am besten für jedes Land, zumindest aber für jede Region so genau wie möglich abschätzen können.

A) Was denkst du, wie gut wird man in der Zukunft die Emissionen der einzelnen Länder/Regionen durch verschiedene Messsyteme kontrollieren können und welche Messungen sind momentan verfügbar?

Dies ist eine sehr schwierige Frage. Es gibt drei verschiedene Verfahren, um regionale Bilanzen zu quantifizieren, die einzeln oder in Kombination zusammen genutzt werden können:

(1) Mit Hilfe von atmosphärischen, sehr genauen, kalibrierten Konzentrationsmessungen: Man misst z.B. in Irland und in Ostpolen die CO2 Konzentration. Wenn man annimmt, dass der Wind von Irland nach Polen strömt, kann man aus der beobachteten Zu- oder Abnahme der CO2 Konzentration das auf dem Weg der Luft über Europa zugemischte, resp. entzogene CO2 schätzen. In der Praxis nutzt man ein dreidimensionales, zeitabhängiges Transportmodell, welches die Winde aus einem Modell der Wettervorhersage nutzt, um den Weg der Luft genauer zu beschreiben. Und man nutzt wenn möglich ein ganzes Netz an Beobachtungsstationen: über Europa mit seiner komplexen Quellen-/Senkenverteilung vorwiegend sogenannte „Tall Towers“, d.h. möglichst hohe Türme, z.B. Sendemasten, welche regional repräsentative Luftschichten erfassen (i.a. 200-500m hoch). Dieses Verfahren, das übrigens mathematisch nicht ganz trivial ist – Stichwort „Inversionsproblem“, wird oft als „Top-down“ Methode bezeichnet. Im wesentlichen liefert es die Netto-Kohlenstoffbilanz einer Region.

(2) Die lokalen CO2 Flüsse lassen sich an einzelnen Standorten mit Hilfe der Eddykovarianzmethode messen. Dabei misst man mit hoher Frequenz (20 Hz) den 3-dimensionalen Wind und die CO2 Konzentration an einem kleinen Turm z.B. über einem Wald oder einer Wiese. Da das Produkt Windgeschwindigkeit mal CO2 Konzentration dem CO2 Fluss entspricht, kann man mit diesem Verfahren durch Aufsummierung den durch die lokale Windturbulenz bewirkten vertikalen CO2 Transport messen. Um die Bilanz einer Region zu erfassen benötigt man repräsentative Eddykovarianz-Messtürme über allen relevanten Ökosystemen. Mit Hilfe von Vegetationskarten und Fernerkundungsdaten kann man die Punktmessung dann hochskalieren. Dieses Verfahren wird oft als „bottom-up“ Methode bezeichnet.

(3) CO2 Bilanzen einer Region lassen sich auch durch Inventurdaten ermitteln. Die Emissionen aus der Verbrennung von Kohle, Öl und Gas lassen sich nach wie vor am besten aus Statistiken des regionalen Verbrauchs dieser Energieträger quantifizieren. Auch die CO2 Bilanz von Wäldern einer Region lässt sich aus Forstinventaren ermitteln: Forstbesitzer sind interessiert am ökonomischen Wert ihres Waldes, daher werden periodisch alle 5-10 Jahre Inventuren der Dichte, Grössen- und Altersverteilung der Bäume aufgenommen. Da solche Daten oft landesweit vorliegen, lassen sich daraus recht belastbare Inventare der im Wald gespeicherten Kohlenstoffvorräte schätzen. Die Änderungen dieser Vorräte entspricht dann der regionalen Kohlenstoffbilanz dieser Waldflächen.

Jedes dieser Verfahren hat seine Stärken und Schwächen. Im Rahmen eines EU-weiten Projektes „CarboEuropeIP“ haben wir die verschiedenen Methoden verglichen und zeigen können, dass sie konsistente Ergebnisse zeigen, jedenfalls wenn man sie über den gesamten Kontinent aufsummiert. Generell gilt: je grösser die Region, desto genauer ist die top-down Methode, je kleiner die Region, desto besser ist das bottom-up Verfahren; vorausgesetzt, es sind genügend Messstationen vorhanden. Auf Grund dieser Erfahrung bauen wir zur Zeit auf europäischer Ebene das „Integrated Carbon Observation System (ICOS)“ auf. Dieses System, basierend auf allen drei oben angesprochenen Verfahren, soll langfristig die CO2 Bilanz Europas mit einer hohen räumlichen (10 x 10 km) und zeitlichen (wöchentlich) Auflösung dokumentieren. Bis dahin ist es allerdings noch ein weiter Weg. Aber der Aufbau und Betrieb der Messnetze bestehend aus einem atmosphärischen Stationsnetz, einem terrestrischen Netz von Eddykovarianzstationen und einem ozeanischen Netz basierend auf automatischen Messungen auf Fähr- und Frachtschiffen, zusammen mit den notwendigen zentralen Einrichtungen (Labore, Datenbanken etc.) geht voran. Als europäische Infrastruktur wird ICOS von Finnland aus koordiniert.

Mittelfristig wird das Konzept von ICOS ergänzt werden durch Fernerkundungsdaten von neuen Sensoren auf Satelliten. Zur Zeit kann die Fernerkundung die existierenden in situ Beobachtungen nur ergänzen aber in 5-10 Jahren dürfte sich dies ändern. Neue Verfahren, z.B. aktive Verfahren (LIDAR) könnten die regionale und globale Konzentrationsverteilung von CO2 und anderen Spurengasen (z.B. Methan) in der Atmosphäre erfassen und kartieren. Daraus lassen sich dann die zu Grunde liegenden raumzeitlichen Verteilungen der Quellen und Senken dieser Gase berechnen. Aber bis dies soweit ist, müssen diese Satelliten wirklich fliegen und genügend genaue Messungen erzeugen. Bis dahin ist es noch ein weiter Weg.

B) Vor kurzem meldete etwa die Presse, dass Chinas Emissionen um ganze 20% falsch berechnet sein könnten. Wie kann es immer noch zu solchen Löchern im Budget kommen? Etwa hier bei Reuters.

Dies ist nicht nur ein Presseartikel, sondern basiert auf einer seriösen, begutachteten Studie von Guan et al., 2012, in Nature Climate Change. Die Forscher des „Global Carbon Project“ glauben, dass sie die globalen fossilen Emissionen mit einer Genauigkeit (±1 sigma) von etwa 5% im Griff haben. Die Emissionen einzelner Länder sind allerdings unsicherer, aber man glaubt, dass die regionalen Unsicherheiten unabhängig sind und sich bei der Aufsummierung zum Teil aufheben. Wenn Guan et al. recht haben, dann ist dies allerdings Wunschdenken.

5) Die Gründe für die natürlichen Schwankungen des CO2 waren immer sehr umstritten. Möglicherweise das gröszte Rätsel von allen ist der um ca. 100ppm niedrigere glaziale CO2 Wert, für dessen Erklärung man sicher einen Nobelpreis der Geowissenschaften bekäme, wenn es den einen gäbe. Warum ist es so schwierig dort irgendwelche Fortschritte zu machen?

Dies ist sicher eines, wenn nicht gar DAS spannendste Problem der Biogeochemie-Zunft. Wir bezeichnen es oft als „Biogeochemie-Enigma“. Leider fehlt uns bis jetzt der passende Rosetta-Stein oder ein Alan Turing um den Code zu knacken. Hypothesen gibt es zuhauf; und während der letzten Dekaden wurden unzählige Paleo-Datensätze erarbeitet, die ein Licht auf den einen oder andern Aspekt des Problems werfen. Die Schwierigkeit liegt u.a. darin begründet, dass auch der Zustand des physikalischen Systems (Temperaturen, Ozeanzirkulation, Niederschlagsverteilung, Eisbedeckung etc.) während der Kaltphasen nur ungenau bekannt ist. Dass der atmosphärische CO2 und CH4 Pegel während der Kaltphasen tiefer lag als im Holozän ist eigentlich plausibel, aber warum beim CO2 immer etwa 100 ppm während der letzten 4 glazialen Zyklen? Und davor, als der Temperaturunterschied zwischen Warm- und Kaltphasen kleiner war, schwankte die CO2 Konzentration auch nur um etwa 70 ppm…

6) Es gab ja mal einen gröszeren Konflikt zwischen der Eiskern-Community, die du ja als Berner besonders gut kennst, und denjenigen, die das CO2 vergangener Zeiten über die Analyse der morphologischen Eigenschaften von fossilierten Blättern (Stomataanzahl) rekonstruieren wollen. Während die Eiskerne langsame und träge Bewegungen des CO2 auf Skalen von ca. 1000 Jahren sehen, wackelt es bei den Paleobotanikern wild hin und her (Groeszenordnung 50ppm). Was ist denn da jetzt so der letzte Zwischenstand?

Die aus der Stomataanzahl rekonstruierten atmosphärischen CO2 Schwankungen sind an sich interessant, wiederspiegeln aber nicht den echten Atmosphärenwert. Ähnliches gilt für Rekonstruktionen der CO2 Konzentration aus 13C/12C Isotopenmessungen an Moosen o.ä. Bei diesen Verfahren hängen die benutzten Transferfunktionen zwischen der Messgrösse (Stomatadichte, 13C/12C Isotopenverhältnis) und der geschätzten CO2 Konzentration von vielen weiteren Einflussgrössen ab, die quantitativ schwer rausgerechnet werden können. Die Transferfunktionen basieren zudem im wesentlichen auf empirischen Beziehungen, welche die zu Grunde liegenden komplexen biologischen Prozesse nur beschränkt darstellen. Bei den Eiskerndaten hat man ein grösseres Vertrauen, da der Gas-Einschluss im Firn und Eis ein physikalischer Prozess ist, den man modellieren kann und wo man das Einschlussmodell mit Messungen von anderen Gasen oder deren Isotopenzusammensetzung überprüfen kann.

Schnelle natürliche Schwankungen im atmosphärischen CO2 wären aus der Sicht der Dynamik des Kohlenstoffkreislaufs auch schwierig zu verstehen. Da der Ozean das atmosphärische CO2 puffert, müssten enorme Mengen Kohlenstoff im System verschoben werden: Um eine Änderung des atmosphärischen CO2 um 50 ppm über 50 Jahre zu bewirken müssten über 200 PgC emittiert werden – woher sollten diese auf die Schnelle kommen? Dennoch besteht natürlich ein grosses Interesse, die vergangene CO2 Konzentration mit einer von den Eiskernmessungen unabhängigen Methode zu ermitteln.

7) Nicht nur die Klimawissenschaften auch das Studium der biogeochemischen Zyklen hat ja seine Skeptiker. Woher weiss man eigentlich, dass der CO2 Anstieg der letzten 200 Jahre zu fast 100% anthropogen ist? Gibt es da wirklich noch eine echte Unsicherheit?

Im neuen IPCC Bericht benutzen wir hierzu das Attribut „with a very high level of confidence“. Dies stützt sich auf mehrere, voneinander unabhängige Befunde: (1) die beobachtete Abnahme des Luftsauerstoffs während der letzten 20 Jahre ist konsistent mit Sauerstoffverbrauch durch die Verfeuerung der fossilen Brennstoffe; (2) die beobachtete Abnahme des 13C/12C Isotopenverhältnis am atmosphärischen CO2 verlangt zur Erklärung eine im 13C/12C abgereicherte CO2 Quelle, hier kommt nur die Biosphäre oder die fossilen Brennstoffe in Frage; (3) das CO2 aus fossilen Brennstoffen hat kein Radiokohlenstoff, daher wird in der Atmosphäre eine Abnahme des 14C beobachtet; (4) da die meisten anthropogenen CO2 Emissionen in der Nordhemisphäre stattfinden, ergibt sich ein kleiner N-S Konzentrationsgradient, der über die letzten 50 Jahre sehr genau den Emissionen folgt; und (5) die nahezu exponentielle Zunahme des CO2 in der Atmosphäre während der letzten 200 Jahre folgt dem nahezu exponentiellen Anstieg der Emissionen mit der selben Zeitkonstante. Zwar könnte jeder einzelne dieser Befunde potentiell mit einem spitzfindigen ad hoc Argument entkräftet werden, aber in der Gesamtschau belegen sie eindrücklich die These, dass der CO2 Anstieg durch den Menschen verursacht ist.

Kommentare (36)