Wenn man schnelle Bewegungen auf einem Foto festhalten will, dann braucht man kurze Belichtungszeiten – handelsübliche Kameras haben meist 1/1000s im Angebot; das reicht aus, um auch schnelle Bewegungen bei Sport noch irgendwie auf den Sensor zu bekommen (vorausgesetzt, es ist hell genug). Hochgeschwindigkeitskameras schaffen auch noch deutlich höhere zeitliche Auflösungen (in einem Forschungsprojekt, an dem ich mal beteiligt war, wurden Bilder mit etwa einer Millionstel Sekunde Belichtungszeit aufgenommen, um zu gucken, was passiert, wenn man Metalle bearbeitet). Aber auch in einer Millionstel Sekunde legt Licht immerhin noch eine Strecke von knapp 300 Metern zurück – insofern sind auch diese Kameras langsam.

Aber bevor wir uns die richtig schnellen Kameras angucken, hier zur Einstimmung aufs Thema ein schickes Video eines platzenden Ballons, aufgenommen mit 1400 Bildern pro Sekunde:

(Youtube-Video von Yo Suzuki)

Schon ziemlich nett – aber wie gesagt, immer noch recht langsam.

Die zur Zeit schnellsten Kameras sind so genannte “Streak”-Kameras (auf deutsch wohl “Schlieren-Kamera” oder “Schmier-Kamera”).

[Hmmm – hier merkt der Blogger, dass er von moderner Optik und Technik nicht wirklich viel Ahnung hat. Soll man so einen Artikel wirklich schreiben, wenn man nicht genau versteht, wie diese Kamera eigentlich funktioniert? Auf der anderen Seite ist das Thema aber zu cool, als dass man nicht drüber schreiben könnte. Ach was, dass man keine Ahnung hat, kann man ja geschickt kaschieren – wird schon keiner merken…]

So eine handelsübliche Streak-Kamera verwendet einen Trick, um eine hohe Zeitauflösung hinzubekommen: Sie opfert eine Raumdimension, um das Signal in der Zeit auflösen zu können – letztlich kann man also nur eindimensionale Bilder aufnehmen (aber man kann den Prozess mehrfach wiederholen und damit doch ein 2D-Bild bekommen). Dazu wird das Licht, das aufgenommen werden soll, auf eine Photokathode geleitet. Dort kann es Elektronen herausschlagen (das ist der photoelektrische Effekt, den das Nobelpreiskommittee ausgenutzt hat, um Einstein seinen Nobelpreis zuzuschustern, ohne das Wort “Relativität”verwenden zu müssen [Rafinierter Blogger-Trick: Wenn man irgendwas nicht so ganz genau erklären will, dann einfach ein bisschen vollkommen unnötige Randinformationen einstreuen, das unterbricht den Lesefluss und keiner merkt (hoffentlich), dass das alles etwas wischi-waschi ist. Außerdem können dann alle wieder das Universal-Wissen des Bloggers bewundern…])

Das Licht trifft also auf die Photokathode und zwar – weil wir ja ein Signal in der Zeit auflösen wollen – nicht genau an allen Punkten zugleich. Das kann man ausnutzen, um die herausgeschlagenen Elektronen auseinanderzudröseln: Dazu legt man ein zeitlich sehr schnell variierendes elektrisches Feld an, so dass Elektronen, die zu unterschiedlichen Zeiten losgeschlagen wurden, unterschiedlich stark beschleunigt werden. Jetzt braucht man nur noch einen Detektor für die Elektronen (da reicht anscheinend ein normaler CCD-Chip wie in einer Kamera), und schon bekommt man ein eindimensionales Bild. Man kann das Ganze natürlich mehrfach wiederholen und damit dann aus mehreren solcher Bilder einen Film zusammensetzen – das ist wohl auch der Trick, mit dem 2011 diese Aufnahmen hier gemacht wurden:

(Visualizing Light over a Fruit with a Trillion FPS Camera, Camera Culture Group, Bawendi Lab, MIT )

Hier wurde ein Femtosekundenlaser über das Objekt geführt und dann wurden jeweils Einzelbilder gemacht und hinterher zu einem Film zusammengesetzt. [Hoffentlich habe ich das halbwegs richtig erklärt?]

[Hmm, da gucken wir ja irgendwie Licht auch schon beim Ausbreiten zu – eigentlich doof, denn das sollte ja erst mit der neuen Kamera gehen, die gleich erst kommt. Ob das wen stört?]

Auch wenn diese Bilder natürlich schick sind, sind sie trotzdem letztlich eindimensional und erst nachträglich wieder zusammengesetzt, was auch nur klappt, weil sich die Szene immer exakt wiederholen lässt. Ein echter 2D-Schnappschuss ist so nicht gelungen, insofern ist der Film also ein wenig geschummelt. [Glück gehabt, so ganz hat man Licht eben doch nicht beim Ausbreiten beobachtet…]

Besser klappt das mit dem neuen Kamera-System, das gerade in Nature vorgestellt wurde. Dabei verwendet man einen raffinierten Trick: Man überlagert das Bild, das man aufnehmen möchte, mit einem “zufälligen” (eigentlich pseudo-zufällig, weil die verwendeten Zufallszahlen von einem Computeralgorithmus generiert werden [Ha, wieder der Ablenkungstrick!] ) Muster, quasi einem Rauschen. Dazu schickt man das Signal auf eine Anordnung von Mikrospiegeln (ein digital micromirror device) [Hey, cool, ich habe gerade den Artikel hier gefunden, da kann ich noch ein bisschen was klauen…], die das Signal unterschiedlich stark reflektieren.

Am Ende hat man also ein Signal, dem quasi ein Rauschen überlagert ist – jeder der sich schon mal über blöde farbige Kleckse in einem Digitalfoto geärgert hat weiß, dass man das eigentlich nicht so gern hat. Rauschen sorgt dafür, dass man Informationen verliert – da gewinnt man doch nichts!?

Stimmt. Man nutzt bei dieser Kamera aber aus, dass man keine beliebigen Szenen fotografiert, sondern solche, bei denen wenig Signal und viel Hintergrund vorhanden ist, beispielsweise eben Lichtflecken. Im Artikel heißt das vornehm, dass das Signal “spatiotemporal sparsity” besitzt , also “raumzeitlich ausgedünnt” ist. [Toll, ich habe ein fies klingendes Fachwort aus dem paper geholt und erklärt – dann denkt hoffentlich jeder, dass ich den Rest auch verstanden habe und es im Zweifel an ihm selbst liegt, wenn die Erklärung etwas unklar wirkt.]

Das Bildsignal wird dann auf eine Streak-Kamera gelenkt. Dort sorgt jetzt wieder das elektrische Feld dafür, dass die Elektronen je nach genauer Zeit, zu der das Signal eintrifft, unterschiedlich stark beschleunigt werden. Das Bild wird dabei sozusagen “aufgefächert” – die Information wird auf mehr Bildpunkte in der CCD-Kamera verteilt, als wir am Ende als Bildauflösung haben wollen. Das erlaubt es dann mit einem cleveren Optimierungsalgorithmus [wie immer der funktioniert, will hoffentlich wirklich niemand wissen…] die eigentliche Bildinformation zu rekonstruieren.

[Hmm, irgendwie verstehe ich noch nicht so ganz, ob man da nun ein einzelnes Bild rekonstruiert oder gleich mehrere. Steht weder im nature-Begleitartikel so richtig klar drin, noch habe ich es im Artikel verstanden. Mist, das fragt bestimmt einer in den Kommentaren, wenn ich das nicht erkläre. – Hey, Moment mal, vielleicht lohnt es sich doch mal, auf die Formeln im Artikel zu gucken, die sehen ja gar nicht so kompliziert aus. Tatsächlich, da steht man rekonstruiert I(x,y,t), also die Bildinformation über die Zeit.]

Das besondere an der neuen Technik ist, dass sie es erlaubt, aus einem einzigen “Bild” auf der CCD-Kamera mehrere zeitlich hintereinander liegende Teilbilder zu rekonstruieren. [Hey – zum paper gibt es noch ein bisschen Extra-Material, das sogar bei nature frei verfügbar ist. Das klaue ich sofort.] Ein bisschen klarer wird das vielleicht mit diesem Bild (aus den “extended data figures):

Aus Gao et al., s.u. extended data

Der blaue Klotz soll die Bildinformation darstellen – die hat drei Komponenten, eine in x- und y-Richtung und eine für die Zeitabhängigkeit. Dann wird dem ganzen das zufällige Muster überlagert und dann durch die streak-Kamera das Signal sozusagen verkippt (temporal shearing). Auf der CCD-Kamera hat man dann Bildinformation, bei der aber jedes Pixel Informationen aus mehreren Zeitpunkten vereint (der gescherte Klotz wird sozusagen von oben auf den CCD-Chip abgebildet). Aus dem Endsignal (im Bild das Em,n) wird dann mit einem Algorithmus das ursprüngliche Signal rekonstruiert – was nur klappt, weil man die überlagerte Störung genau kennt und weil das Ausgangssignal zu einem großen teil keine Bildinformation enthält (das war ja das mit der “spatiotemporal sparsity”). [Hey, klingt jetzt wirklich fast so, als hätte ich es doch verstanden – hmm, habe ich es vielleicht sogar verstanden?]

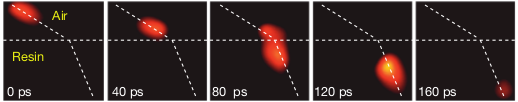

Mit dieser schicken Technik kann man dann beispielsweise aufnehmen, wie Licht an der Grenzfläche zwischen zwei Medien gebrochen wird (Videos dazu gibt es hier auf der Nature-Seite, kann ich nur sehr empfehlen). So sieht das aus:

Aus Gao et al., s.u.

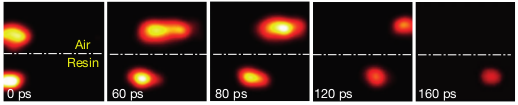

Und auch, dass Licht in Luft schneller läuft als in einem optischen Medium, kann man jetzt direkt sehen – hier das Wettrennen zweier Lichtpulse:

Aus Gao et al., s.u.

[So, ich hoffe, alle finden diese Bilder genau so cool wie ich und vergessen darüber, dass die Erklärung der Kamera wirklich etwas unklar bleibt. Ach ja, solche Artikel müssen ja auch immer noch erklären, wozu irgendwas gut ist – cool allein reicht heutzutage ja oft nicht. Gibt vielleicht auch einen netten Abschluss des ganzen.]

Nutzen kann man diese Technik vielleicht, um die Ausbreitung von Licht in Glasfasern oder andere optische Phänomene zu studieren – beispielsweise das Verhalten von Licht in Metamaterialien [hoffentlich sind alle beeindruckt, was ich alles weiß…], mit denen man Dinge unsichtbar machen kann (etwas ähnliches habe ich ja auch mal hier und hier beschrieben [Links auf eigene Artikel sind immer gut $$$]). Aber auch ohne solche Anwendungen ist es einfach cool, Licht beim Ausbreiten zuzugucken. [Hey, ich bin theoretischer Physiker – was interessieren mich Anwendungen?]

[Puh, geschafft. Ob irgendjemand merkt, dass das hier nicht so ganz perfekt erklärt war? Wenn ich Glück habe, denken alle, es liegt einfach nur daran, dass ich so unglaublich schlau bin, wenn sie meine Erklärungen nicht verstehen. Wenn die wüssten…]

Single-shot compressed ultrafast photography at one hundred billion frames per second

Liang Gao, Jinyang Liang,Chiye Li,Lihong V. Wang

Nature 516, 74–77

Kommentare (20)