Letzte Woche hat das Event Horizon Telescope (EHT) das erste Bild eines schwarzen Lochs veröffentlicht. Das war eine großartige wissenschaftliche Leistung, aber auch eine gewaltige technische Aufgabe. Ein so weit entferntes Objekt zu sehen ist nicht einfach. Dazu braucht es ein großes Teleskop. Größer als alles, was wir vernünftigerweise bauen können. Dass es trotzdem geklappt hat, liegt an einer sehr ausgeklügelten Technik. Sie nennt sich Apertursynthese beziehungsweise Very Long Baseline Interferometry (VLBI) (Das ist nicht exakt das selbe, was aber jetzt für den Zweck dieses Artikels nicht so wichtig ist).

In den Himmel schauen kann man immer. Was man dabei alles sehen kann, hängt allerdings vom Auflösungsvermögen des dabei verwendeten optischen Instruments ab. Mit unseren Augen können wir zum Beispiel auf dem Mond nichts sehen, was kleiner als 130 Kilometer ist. Wollen wir mehr sehen, brauchen wir ein größeres Instrument. Jetzt stellen wir uns vor, wir wollen eine Orange sehen, die dort auf dem Mond herum liegt (nur theoretisch, dort liegen in Wahrheit natürlich keine Orangen herum). Also ein Objekt mit etwa 7 Zentimeter Durchmesser in einer Entfernung von knapp 400.000 Kilometer. Das ist wirklich schwer zu sehen. Die Orange hat eine Größe von 36 Mikro-Bogensekunden. Das bedeutet: Teilen wir den kompletten Himmel in 360 Grad, dann hat ein Grad 60 Bogenminuten und eine Bogenminute 60 Bogensekunden. 36 Millionstel einer Bogensekunde wären dann der Winkel, den die Mondorange am Himmel einnimmt. Zum Vergleich: Der Mond selbst ist 30 Bogenminuten groß!

Jetzt will man aber nicht unbedingt fiktive Orangen am Mond beobachten. Aber ungefähr genau so groß erscheint das schwarze Loch im Zentrum der Galaxie M87. Es (bzw. sein Ereignishorizont) ist zwar deutlich größer als eine Orange. Aber dafür auch 54 Millionen Lichtjahre weit weg. Am Ende kommt man auch hier auf ungefähr 40 Mikro-Bogensekunden und will man es sehen, braucht man ein Teleskop, dessen Auflösung gut genug ist. Ein Teleskop mit einem Durchmesser von mehr als 10.000 Kilometer! So etwas zu bauen ist quasi unmöglich und wenn wir es doch schaffen würden, wäre es vermutlich schwer irgendwo auf der Erde den nötigen Platz zu finden, um es aufzustellen. Aber wir müssen gar nicht das Teleskop bauen. Es reicht auch eines, das ein paar Löcher hat. Und diese Löcher können durchaus sehr groß sein.

Ein Teleskop mit einem Loch klingt nach einer schlechten Idee. Ist aber nicht so schlimm, wie man es sich vorstellt. Die Aufgabe eines Teleskops ist es ja, Licht zu sammeln. Wenn es ein Loch hat, sammelt es nur ein bisschen weniger Licht – aber ist immer noch in der Lage, aus diesem Licht ein Bild zu machen. Das hat zum Beispiel das 2,7-Meter-Teleskop am McDonald-Observatorium in Texas gezeigt, auf das ein Mitarbeiter 1970 aus ungeklärten Gründen mit einer Pistole geschossen hat. Die Löcher sind heute noch im Spiegel; das Teleskop funktioniert aber weiterhin. Das Auflösungsvermögen des Teleskops wird durch die Ausmaße seines Rands definiert, wie viel lichtreflektierende Fläche dazwischen ist, ist nicht ganz so wichtig (was natürlich auch nicht stimmt – je mehr desto besser – aber für den Zweck dieses Artikels ignorieren wir das mal).

Man kann sich jetzt überlegen, ein WIRKLICH großes Loch absichtlich zu produzieren. Zum Beispiel in dem ich zwei kleine Teleskope nebeneinander stelle. Dann befindet sich zwischen ihnen ein “Loch” – aber wenn man es richtig anstellt, kann man daraus immer noch ein virtuelles Teleskop basteln, dessen Größe dem Abstand zwischen den einzelnen Teleskopen entspricht. Dazu reicht es aber nicht, einfach nur mit jedem der Instrumente ein Bild aufzunehmen. Dann hat man zwar zwei Bilder, aber deren Auflösung entspricht dem Auflösungsvermögen der Einzelteleskope.

Viele einzelnen Teleskope. Oder ein großes Teleskop mit vielen Löchern… (Bild: ESO/C.Malin)

Was man braucht, nennt sich “Interferometrie”! Man muss Licht (und wenn ich “Licht” schreibe, meine ich immer elektromagnetische Strahlung allgemein, also zum Beispiel auch Radiowellen) der beiden Teleskope sammeln und kombinieren. Vereinfacht gesagt schickt man das Licht beider Teleskope in ein Gerät – ein Interferometer – wo es überlagert wird. Dann kriegt man ein Interferenzmuster, also eine Abfolge von hellen und dunklen Bereichen. Hell ist es dort, wo die Lichtwellen der beiden Teleskope sich verstärken; dunkel dort wo sie sich gegenseitig auslöschen. Was macht man jetzt mit so einem Muster, wo man doch ein Bild haben will?

Da kommt jetzt ein kompliziertes, aber sehr wichtiges Stück Mathematik ins Spiel: Die Fourier-Transformation. Darüber habe ich schon ein wenig geschrieben. Simpel gesagt geht es dabei um die Tatsache, dass man jedes Signal (also zum Beispiel eine Lichtwelle) auch als Überlagerung von simplen Sinus-Schwingungen darstellen kann. Je komplexer das Signal ist, desto mehr unterschiedliche Schwingungen braucht man. Die Fourier-Transformation ist nun genau die mathematische Technik mit der man ein Signal in die Überlagerung von Schwingungen umrechnen kann bzw. aus einer Überlagerung von Schwingungen wieder ein Signal rekonstruiert. Das geht auch zweidimensional: Ein Teleskop misst ja die Intensität von Licht am zweidimensionalen Himmel. Diese Helligkeitsverteilung kann man in ein entsprechendes Fourier-Muster aus Schwingungen umrechnen.

Nichts anderes macht – wieder vereinfacht gesagt – das Interferometer. Und aus dem Muster kann man die ursprüngliche Intensitätsverteilung wieder rekonstruieren. Also das Bild des Himmels, das man eigentlich sehen will. Warum aber der ganze Aufwand mit der Interferometrie, wenn man mit einem normalen Teleskop das Bild auch direkt beobachten kann? Da sind wir jetzt bei den “Very Long Baselines” aus der “Very Long Baseline Interferometrie”. Wie genau das Interferenzmuster aussieht, hängt vom Abstand der beiden Teleskope ab und von ihrer Ausrichtung in Bezug auf die Lichtquelle.

Interferenzmuster (Bild: Membeth, gemeinfrei)

Man kann sich das vielleicht so vorstellen: Denkt euch eine Schablone mit hellen und dunklen Streifen, die ihr über den Himmel legt. Durch die hellen Streifen kann man gut schauen, durch die dunklen weniger gut. Je nachdem wo und wie die Streifen die Lichtquelle bedecken, kriegt ihr mehr oder weniger Licht zu sehen. Vielleicht liegt die Quelle komplett in einem hellen Streifen; vielleicht liegt aber auch nur zur Hälfte darin. Und die Lichtquelle ist ja vermutlich auch nicht nur ein einzelner Punkt sondern hat eine Struktur. Dort gibt es helle und dunkle Bereiche und wenn durch die hellen und dunklen Streifen leuchten, kriegt ihr ein ganz bestimmtes Muster. Wenn man nun die Anordnung der Teleskope verändert, kriegt man eine neue Schablone, in der die Streifen dicker oder dünner sind oder anders orientiert sind – und damit ein anderes Muster der Lichtquelle. Je mehr unterschiedliche Anordnungen von Teleskopen man verwendet, desto mehr unterschiedliche Muster kriegt man und desto mehr Informationen über die Struktur der Lichtquelle kann man sammeln. Diese Informationen schmeißt man wieder in die Maschine der Fourier-Transformation und rekonstruiert damit das ursprüngliche Bild der Quelle.

Je weiter die Teleskope auseinander stehen, je länger als die Basislinie ist, desto feiner wird das Streifenmuster der Schablone und desto besser kann man die Quelle auflösen. Um ein virtuelles Riesen-Teleskop zu konstruieren, verteilt man also jede Menge Teleskope über die Welt und schaltet sie in allen möglichen Kombinationen zusammen. Jede Kombination aus zwei Teleskopen liefert eine neue Basislinie, eine neue Schablone und damit ein neues Muster. Die Größe des virtuellen Teleskops und damit sein maximales Auflösungsvermögen entspricht dabei dem größten Abstand zwischen zwei der Einzelgeräte.

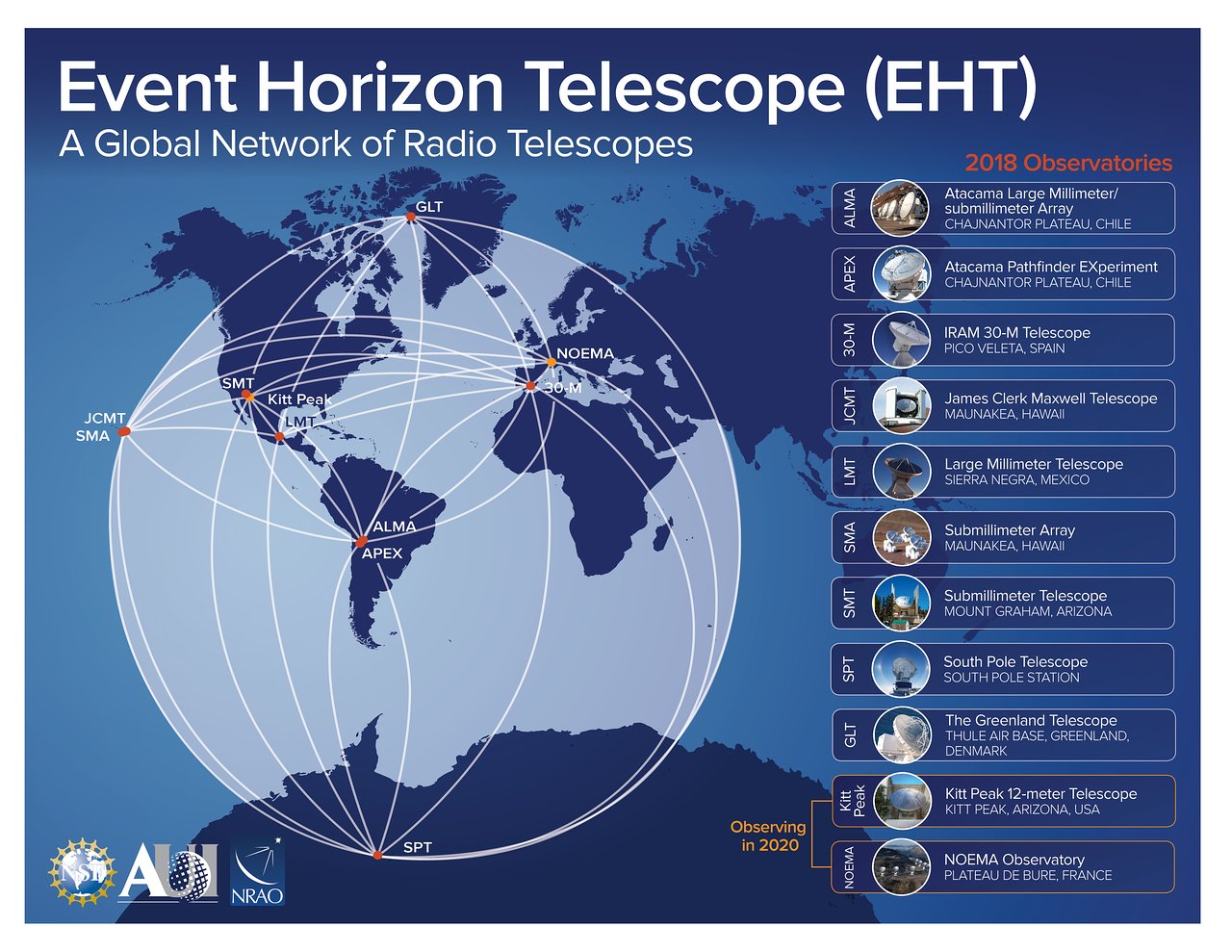

Teleskope des EHT (Bild: EHT)

Genau das hat das Event Horizon Telescope getan. Acht Radioteleskope auf der ganzen Welt wurden eingesetzt um am Ende das Bild des schwarzen Lochs zu erhalten. Das Radiolicht wurde dabei aber natürlich nicht real durch die Gegend zu einem Interferometer geschickt. Das wäre nicht möglich gewesen; immerhin stand eines der Teleskope in Grönland, ein anderes in der Antarktis, ein paar auf Hawaii, und so weiter. Man hat jeweils zur gleichen Zeit die gleiche Region am Himmel beobachtet, alle Daten aufgezeichnet und mit extrem genauen Zeitstempeln versehen (das ging nur durch den Einsatz von Atomuhren). Die ganzen Daten (ein paar Petabyte) wurden auf Festplatten zu einem zentralen Ort geschickt, in einen Supercomputer geladen und dort quasi noch mal als “Playback” abgespielt und dann virtuell überlagert und analysiert. Die eigentlichen Beobachtungen fanden während nur vier Tagen statt, die Auswertung der Daten hat sehr, sehr viel länger gedauert…

Das Event Horizon Telescope hat diese Technik allerdings nicht erfunden. VLBI gibt es schon länger und kommt an vielen verschiedenen Orten zum Einsatz. Man kann die Apertursynthese (also das Simulieren großer Teleskope aus kleinen) im Prinzip auch bei anderen Bereichen der elektromagnetischen Strahlung anwenden. Da ist es aber nicht mehr ganz so einfach wie im Radiobereich. Will man etwa ganz normales Licht auf diese Weise interferieren, kann man das nur direkt tun. Man kann die Informationen in diesem Fall einfach nicht exakt genug aufzeichnen (die Wellenlänge von normalen Licht ist auch viel kürzer als die von Radiowellen) um sie als “Playback” abzuspielen. Man muss die Teleskope hier tatsächlich direkt verbinden, zum Beispiel durch Glasfaserkabel, und das Licht physisch zu einem zentralen Ort schicken wo es zur Interferenz gebracht werden kann. Das klappt nur auf kurze Distanzen, wird aber trotzdem in einigen Großsternwarten gemacht.

Das Event Horizon Telescope hat seine Aufgabe mehr als nur zufriedenstellen gelöst. Aber es wird natürlich nicht aufhören! Auch andere schwarze Löcher wollen beobachtet werden. Und neben den ursprünglichen acht Teleskopen haben sich mittlerweile auch einige andere Sternwarten der Organisation angeschlossen. Es wird also bei zukünftigen Beobachtungen noch mehr Basislinien geben, noch mehr Informationen und damit noch bessere Bilder. Prinzipiell spricht auch nichts dagegen, die Löcher noch ein wenig größer zu machen: Man könnte ein Radioteleskop auch irgendwo im All platzieren und mit den Teleskopen auf der Erde kombinieren. Und wer weiß, was wir dann damit alles sehen können…

Kommentare (93)