Dieser Artikel ist Teil einer fortlaufenden Besprechung des Buchs “Wenn Gott würfelt: oder Wie der Zufall unser Leben bestimmt” (im Original: “The Drunkard’s Walk: How Randomness Rules Our Lives”) von Leonard Mlodinow. Jeder Artikel dieser Serie beschäftigt sich mit einem anderen Kapitel des Buchs. Eine Übersicht über alle bisher erschienen Artikel findet man hier.

Dieser Artikel ist Teil einer fortlaufenden Besprechung des Buchs “Wenn Gott würfelt: oder Wie der Zufall unser Leben bestimmt” (im Original: “The Drunkard’s Walk: How Randomness Rules Our Lives”) von Leonard Mlodinow. Jeder Artikel dieser Serie beschäftigt sich mit einem anderen Kapitel des Buchs. Eine Übersicht über alle bisher erschienen Artikel findet man hier.

——————————————————-

Im ersten Kapitel des Buchs hat Mlodinow anschaulich dargelegt, wie sehr der Zufall unser Leben bestimmt und vor allem dort, wo wir nicht damit rechnen. Das zweite Kapitel hat sich mit den grundlegenden Regeln der Wahrscheinlichkeit beschäftigt. Im dritten Kapitel präsentiert Mlodinow das fiese Ziegenproblem, das unser Unverständnis der Wahrscheinlichkeit eindrucksvoll präsentiert. Das vierte Kapitel beschäftigt sich mit den Methoden zur Berechnung von Wahrscheinlichkeiten die vor allem Blaise Pascal im 17. Jahrhundert entwickelt hat. Das fünfte Kapitel beschäftigt sich mit der Frage, was Wahrscheinlichkeiten in der realen Welt eigentlich bedeuten. Kapitel 6 erklärt die verwirrende Bayesschen Wahrscheinlichkeiten die für unser Alltagsleben von großer Bedeutung sind. In Kapitel 7 wechselte Mlodinow von der Wahrscheinlichkeitsrechnung zur Statistik und die bleibt auch weiterhin das Thema.

Kapitel 8 beschäftigt sich mit der Ordnung im Chaos und den Wegen, diese Ordnung mittels Statistik zu erkennen. Mlodinow zeigt eine der paradoxen Eigenschaften der Statistik: Obwohl viele Vorgänge in unserem Alltagsleben einzeln betrachtet vollkommen willkürlich und chaotisch erscheinen, zeigt die Statistik bei der Betrachtung großer Mengen eine erstaunliche Gleichmäßigkeit. Als Beispiel hat sich Mlodinow die amerikanischen Autofahrer ausgesucht. Jeder Amerikaner fährt jedes Jahr so viel oder so wenig Auto wie es eben gerade nötig war. Im Durchschnitt ist aber jeder von ihnen 14.300 Meilen gefahren. Wollte man, dass die Amerikaner im folgenden Jahr genau die gleiche Durchschnittsstrecke zurücklegen, könnte man sich ein kompliziertes System ausdenken, dass jedem Fahrer eine bestimmte Quote zuweist, damit sich am Ende alles ausgleicht. Oder man lässt sie einfach weiterhin so fahren, wie sie wollen. Und auch wenn jeder einzelne vielleicht völlig anders fährt als im Vorjahr wird am Ende wieder eine ähnliche Durchschnittsleistung herauskommen. Die entsprechende Statistik zeigt das auch: In den betrachteten Jahren unterschieden sich die Strecken nur um 100 Meilen. Einzelprozesse mögen völlig zufällig und chaotisch sein. Die Statistik großer Mengen ist es aber nicht und das macht ihre Besonderheit aus.

Einer der ersten, der das erkannte war John Graunt im 17. Jahrhundert. Er wertete die damals erstmalig ausführlich angelegten Sterbedaten aus und demonstrierte, dass man daraus allgemeine Erkenntnisse über die Gesellschaft gewinnen konnte. Aus den Daten konnte er das eine halbwegs genau Schätzung für die Einwohnerzahl von London durchführen und zeigen, dass man sie bisher völlig überschätzt hatte. Er konnte außerdem berechnen, wie stark sich der Zuzug von Landbewohnern auf die Bevölkerung der Stadt auswirkte.

Graunts Arbeit war der Beginn einer regelrechten Statistikwelle in den Ländern Europas. Überall sammelte man Daten und überlegte, wie man sie am besten auswerten kann. Einer der besonders viele Daten sammelte, war Adolphe Quetelet und er stieß überall in den Daten auf die letzten Kapitel beschriebene Normalverteilung. Quetelet erkannte auch, dass man die Normalverteilung von Daten nutzen konnte, um Betrügereien aufzudecken.

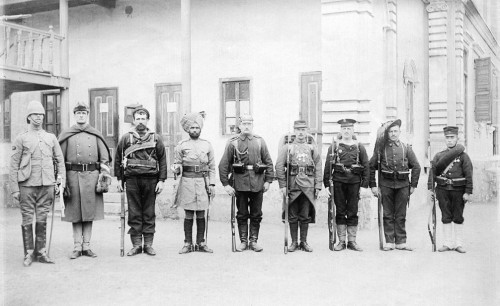

Soldaten der vereinigten acht Staaten von 1900, der Größe nach sortiert: Großbritannien, USA, Australien, British-Indien, Deutschland, Frankreich, Österreich-Ungarn, Russland, Italien, Japan.

Er untersuchte zum Beispiel die Größenmessungen von 10.000 französischen Rekruten und fand, dass sie der Normalverteilung folgten. Mit einer Ausnahme: Es gab ein bisschen zu wenig Männer, die 1,58 Meter groß waren. Bei dieser Größe wich die tatsächlich Verteilung von der erwarteten Normalverteilung ab. Dafür gab es zuviele Männer, die knapp unter 1,58m groß waren. Quetelet schloss daraus, dass bei den Musterungen geschummelt worden war, den 1,58 m war genau die Grenze unter der man als untauglich ausgemustert wurde.

Quetelet war bei seiner statistischen Arbeit darauf aus, die Gesetze zu finden, die die menschliche Gesellschaft beschreiben:

“Menschen werden geboren, leben und sterben nach bestimmten Gesetzen. Und diese Gesetze wurden bis jetzt noch nie studiert.”

Analog zur revolutionären Arbeit Newtons wollte Quetelet eine “Sozialphysik” entwerfen, bei der die menschliche Natur mit Statistik beschrieben werden kann. Das schaffte er zwar nicht ganz, aber er legte den Grundstein für die Arbeit der im nachfolgenden Wissenschaftler (Und er erfand den Body-Mass-Index, der uns heute immer noch auf die Nerven geht). Zum Beispiel Francis Galton, ein Cousin von Charles Darwin. Galton entdeckte zwei fundamentale Prinzipien der Statistik. 1875 untersuchte er Erbsen. Er pflanzte Erbsen verschiedner Größe ein und sah nach, wie groß die daraus wachsenden neuen Erbsen waren. Dabei stellte er fest, dass im Durchschnitt die Nachkommen großer Erbsen kleiner waren als die Vorgängergeneration. Und die Nachkommen der kleinen Erbsen waren größer. Das gleiche stellte er in den Größenmessungen bei Menschen fest. Große Eltern bekommen nicht zwingend große Kinder und umgekehrt. Galton hatte die Regression zum Mittelwert entdeckt: Nach einer Messung die stark vom Mittelwert abweicht ist es wahrscheinlich, dass der nächste Wert wieder näher am Mittelwert liegt wenn der Zufall den Prozess beeinflusst und die Messungen korreliert sind. Wäre es nicht so, dann würde die Größenverteilung der Menschen keiner Normalverteilung folgen (was sie aber tut), denn dann würden große Eltern noch größere Kinder kriegen, die dann noch größere Kinder kriegen, und so weiter. Die Größen sollten dann nicht mehr normalverteilt sein, sondern deutliche Spitzen bei Extremwerten zeigen.

Verschiedene Datensätze und ihr Korrelationskoeffizent. Je mehr die Daten von einer Linie abweichen, desto mehr nähert sich der Koeffizent der Null an (Bild: Public Domain)

Der zweite große Beitrag von Galton zur Statistik war der Korrelationskoeffizent. Man kann zum Beispiel die Größe der Eltern in einem Diagramm auf der einen Achse aufzeichnen und die Größe ihrer Kinder auf der anderen. Wären die Kinder immer genau so groß wie ihre Eltern, dann würde man eine Linie bekommen die in einem Winkel von 45 Grad durch das Diagramm verläuft. Eltern die 1,80m groß sind kriegen Kinder die 1,80m groß sind; Eltern die eins 1,70m groß sind kriegen Kinder die 1,70m groß sind, und so weiter. In der Realität ist das aber wie schon gesagt nicht der Fall und die Datenpunkte liegen nicht alle exakt auf einer Linie. Der Korrelationskoeffizent von Dalton beschreibt nun mathematisch, wie stark die Datenpunkte von der 45-Grad-Linie abweichen. Liegen sie genau auf der Linie, ist der Korrelationskoeffizent gleich 1. Dann wären in unserem Beispiel die Größen von Eltern und Kinder exakt linear zusammenhängend. Wenn es absolut keinen Zusammenhang geben würde und die Daten einfach zufällig im Diagramm verteilt sind, ist der Korrelationskoeffizient gleich 0 (im Falle einer negativen Korrelation – die größten Eltern kriegen die kleinsten Kinder – ist der Koeffizient gleich -1). In der Realität wird der Koeffizient irgendwo dazwischen liegen und zeigt an, wie stark zwei Messgrößen tatsächlich zusammenhängen.

Durch Galtons Arbeit wurde die Statistik Teil der Biologie und ein nützliches Instrument. Aber auch die Physiker waren überzeugt, dass Statistik in ihrer Wissenschaft von Nutzen sein konnte. Wenn große Gruppen von Menschen den gleichen statistischen Gesetzen folgten, dann muss das doch auch für noch größere Gruppen von Atomen und Molekülen gelten, die sich ebenso chaotisch bewegten, wie einzelne Menschen. Physiker wie Ludwig Boltzmann und James Clerk Maxwell entwickelten Methoden, um physikalische Systeme statistisch zu beschreiben. Ein wirklicher Durchbruch gelang aber einem anderen: Albert Einstein.

Den assozieren wir heute meistens mit seiner Relativitätstheorie. Aber Einstein ist nicht umsonst das buchstäbliche Genie und der Inbegriff des Überwissenschaftlers. Er war tatsächlich ein Genie und es gibt kaum einen Bereich der modernen Physik, den er nicht maßgeblich beeinflusst hat. Vielen wird bekannt sein, dass Einstein nicht nur die Relativitätstheorie entwickelt, sondern auch grundlegende Arbeit auf dem Gebiet der Quantenmechanik geleistet hat. Seine Forschung über Statistik ist weniger prominent, aber deswegen nicht weniger genial. Genau wie seine Artikel zu Relativitätstheorie und Quantenmechanik (und Einsteins Doktorarbeit) erschienen die Ergebnisse im Jahr 1905. Im Artikel “Über die von der molekularkinetischen Theorie der Wärme geforderte Bewegung von in ruhenden Flüssigkeiten suspendierten Teilchen” untersuchte Einstein die sogenannte Brownsche Bewegung.

Simulation der Brownschen Bewegung (Bild: Francisco Esquembre, Fu-Kwun and lookang, CC-BY-SA 3.0)

Die wurde vom schottischen Botaniker Robert Brown im 19 Jahrhundert bei seinem mikroskopischen Experimenten entdeckt. Brown betrachtete Blütenpollen die im Wasser schwammen und sah, dass sie ständig leicht zitterten und sich auf zufälligen Bahnen durchs Wasser bewegten. Diese Bewegung hörte nie auf und Brown hielt sie für die allen Lebewesen innewohnende “Lebenskraft”. Diese These musste er allerdings aufgeben, als er die gleiche Zufallsbewegung auch bei leblosen Gesteins- oder Metallteilchen entdeckte. Eine Erklärung für Bewegung schien die neue statistische Physik von Boltzmann und Maxwell zu bieten. Aus der chaotischen Bewegung unzähliger chaotischer Atome und Moleküle konnte man damit die Eigenschaften ganzer physikalischer Systeme beschreiben. Die Moleküle in einer Flüssigkeit bewegen sich alle ständig zufällig kreuz und quer und stoßen zusammen; miteinander und mit allem anderen, was dort noch herum schwimmt: Zum Beispiel Blütenpollen. Die Physiker waren aber skeptisch was die neue statistische Physik anging weil sie noch keine konkreten Vorhersagen machte die man im Experiment überprüfen konnte. Und außerdem schien die Bewegung der Moleküle keinen Einfluss auf Blütenpollen oder ähnliches haben: Moleküle sind viel zu klein und leicht um große Objekte wie Pollen zu bewegen. Und sie bewegen sich im Wasser so schnell und stoßen so oft mit den Pollen zusammen, dass sie die vergleichsweise langsame Bewegung der Pollen nicht verursachen konnten.

Und dann kam Einstein. Er erkannte, dass die beiden Probleme sich zusammengenommen aufheben. Ja, die Moleküle sind zu leicht um die Pollen zu bewegen und wenn sie rein zufällig aus allen möglichen Richtungen auf die Pollen stoßen, dann hebt sich ihr Einfluss gegenseitig auf. Aber wenn zufällig gerade sehr viele von ihnen aus der gleichen Richtung gegen einen Pollen stoßen, dann kann ihre kombinierte Kraft ausreichen, ihn ein Stück zu bewegen. Einstein entwickelte eine mathematische Methode mit der man berechnen kann, wie oft solche Zufälle vorkommen und wie sich das auf die Bewegung der Pollen auswirken würde. Und das, was seine Theorie vorhersagte, war genau das, was man auch beobachten konnte. Die korrekte Statistik erlaubte es ihm, die dem Chaos innewohnende Ordnung zu entdecken…

Kommentare (19)