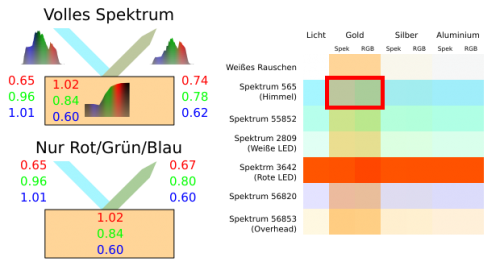

Daher habe ich mich dann zuhause dazu entschieden, das ganze mal am Computer zu simulieren. Dazu habe ich das zurückgestrahlte Licht für verschiedene Materialien unter verschiedenen Beleuchtungen berechnet. Ich habe jeweils für das Licht und das Reflektionsspektrum den RGB-Wert bestimmt und einmal direkt damit gerechnet. Und zum Vergleich das ganze nochmal mit dem gestamten Spektrum durch gerechnet und erst anschließend für das reflektierte Licht einen RGB-Wert bestimmt und die beiden verglichen. Leider konnte ich für detailierte Spektren so gut wie keine Quellen finden, die eine Lizenz mit offenen Nutzungsbedingungen hatten. Deswegen beschränke ich mich hier auf ein paar von mir rekonstruierte Spektren [1] und solche Lichtspektren [2], die zwar frei verwendbar sind, dafür aber nicht zu 100% genau sind. Das macht allerdings nichts, weil der Effekt selbst dadurch nicht beeiflusst wird und ich zum Vergleich noch Simulationen mit Spektren aus anderen Quellen mit ähnlichem Ergebnis gemacht hatte.

Das Ergebnis meiner kleinen Simulation scheint meine Vermutung zu bestätigen. Für Gold sind klare Unterschiede zu erkennen, wenn statt dem vollen Spektrum nur mit Rot, Grün und Blau gerechnet wird. Allerdings sind bei Silber die Unterschiede kaum noch zu erkennen und bei Aluminium gar nicht mehr vorhanden. Man muss sich also bei unserer heutigen Computergrafik noch keine großen Gedanken über die Grenzen von RGB-Farben machen. Zumindest solange man mit den gängigen Verfahren noch andere wesentlichere Abweichungen erhält. Nähert man sich allerdings der Perfektion oder braucht man aus anderen Gründen (zum Beispiel weil man an den Dispersionseffekten interessiert ist oder für wissenschaftliche Simulationen). Und weil das natürlich auch schon länger bekannt ist, gibt es genau für solche Zwecke auch Programme. Mit der Open-Source Software Pov-Ray oder mit Blender und kann das jeder selbst ausprobieren. Allerdings sind diese nicht gerade ganz leicht zu bedienen. Und wäre ich gleich auf die Idee gekommen, das damit zu berechnen (das Program enthält eigene Spektren), hätte ich mir etwas Arbeit gespart, wäre aber mit Sicherheit nicht über die vielen interessanten Artikel zu dem Thema gestolpert. So oder so freue ich mich natürlich auch weiterhin über jeden Regenbogen.

P.S.: Sollte es Interesse an diesem oder ähnlichen Themen geben, werde ich versuchen auch außerhalb des Schreibwettbewerbs etwas dazu zu schreiben und die Chance nutzen, dabei wieder viel neues zu lernen.

Regenbogen über dem Lipno Stausee (Bild: Alexis Dworsky, CC BY 2.0 DE)

[1] Reflektions-Spektren der Metalle aus einem Diagram von DrBob bei Wikipedia entnommen (CC BY-SA 3.0 Unported, https://en.wikipedia.org/wiki/File:Image-Metal-reflectance.png)

[2] Licht-Spektren von https://spectralworkbench.org/ (Public Domain)

————————————————-

Hinweis zum Autor: Dieser Artikel wurde von Johannes (“JoselB”) geschrieben: “Ich bin Softwareingenieur und das ist mein erster Blogbeitrag seit meiner kurzen OpenSource-Zeit während dem Studium.”

Kommentare (21)