Wäre es nach den Meinungsforschern des Literary Digest gegangen, wäre 1936 nicht Franklin D. Roosevelt zum US-Präsidenten gewählt worden, sondern Alfred Landon. Pearl Harbor, D-Day, das Manhattan-Projekt – die Geschichte des 20. Jahrhunders wäre zweifellos anders verlaufen. Statt dessen bedeutete die Wahlprognose das Ende des Digest.

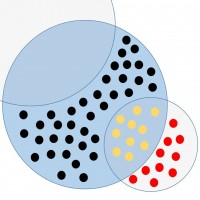

Zunächst ein wenig Theorie: Für alle durch eine Zufallsauswahl zustande gekommenen Stichproben gilt, dass eine Vergrößerung des Stichprobenumfangs die Wahrscheinlichkeit einer größeren Abweichung der erfassten Merkmalsverteilungen von denen der Grundgesamtheit sinken lässt. Die Aussage, eine größere Stichprobe führe zu genaueren Schätzungen, lehnt sich an den zentralen Grenzwertsatz an – ein Theorem aus der Inferenzstatistik. Kommen bei Befragungen oder anderen Erhebungen jedoch nicht-zufallsgesteuerte Auswahlverfahren zum Einsatz oder treten Mängel bei der Auswahl auf, führt eine hohe Teilnehmerzahl dagegen nicht automatisch zu einer hohen Aussagekraft der Ergebnisse, auch wenn dies fälschlicherweise häufig so dargestellt wird.

Das sprichwörtlich klassische Beispiel für einen Mangel im Auswahlverfahren, der auch durch eine sehr große Stichprobe nicht ausgeglichen werden konnte, ist das so genannte „Literary Digest Disaster” von 1936. Was sich damals genau zugetragen hat, warum die Verwendung des Begriffs „Desaster” keineswegs übertrieben ist und was die (Online-) Marktforscher von heute aus der ganzen Misere noch lernen können, darüber möchte ich heute in diesen etwas längeren Blogpost berichten. Wer sich nicht für Wahlforschung oder Geschichte erwärmen kann, sei darum herzlich dazu aufgefordert, den „Frischen Wind” heute (ausnahmsweise) einmal links liegen zu lassen.

1936 – Landon vs. Roosevelt

Für alle anderen ein kleiner Rückblick ins Jahr 1936: Der demokratische Amtsinhaber Franklin D. Roosevelt steht kurz vor dem Ende seiner ersten Amtszeit und muss sein Mandat gegen den republikanischen Herausforderer Alfred M. Landon, den Gouverneur von Kansas, verteidigen. Zu dieser Zeit erfreut sich das wöchentlich erscheinende Magazin „Literary Digest” einer großen Popularität. Die Herausgeber des Digest können angesichts der Wahl auf eine erstaunliche Erfolgsserie zurückblicken: Mit Hilfe von Meinungsumfragen war es nämlich gelungen, die Sieger der Präsidentschaftswahlen von 1916, 1920, 1924, 1928 und 1932 korrekt vorherzusagen. Auch für 1936 plante das Magazin wieder eine großangelegte Wahlbefragung – und dieses Jahr wollte man alles bisher dagewesene übertreffen und den Wahlausgang mit der größten Wählerbefragung aller Zeiten noch genauer vorhersagen.

Die bisherigen Digest-Wahlumfragen basierten auf Quasi-Vollerhebungen unter der Leserschaft des Magazins. Als Publikation, die keinem politischen Lager zugeordnet werden konnte, besaß der Digest Leser sowohl unter den Anhängern der Republikaner wie auch der Demokraten – und natürlich der unpolitischen Mehrheit. Einige Monate vor der Wahl lagen einer bestimmten Ausgabe des Digest „Stimmzettel” im Postkartenformat bei, auf denen ein Kandidat angekreuzt werden konnte und die anschließend zum Verlag zurückgeschickt wurden. Auf diese Weise führte das Magazin quasi eine Vollerhebung unter der eigenen Leserschaft durch, wobei natürlich längst nicht jeder teilnahm (dazu später mehr).

Die größte Stichprobe der US-Wahlforschung

Für 1936 hatte man sich vorgenommen, die Genauigkeit der bisherigen Befragungen dadurch zu übertreffen, dass man eine deutlich vergrößerte Stichprobe zog. Das bisherige Verfahren mit den beiliegenden Stimmzetteln wurde durch eine der ersten Telefonbefragungen überhaupt ergänzt, basierend auf einer Zufallsauswahl anhand des Telefonregisters sowie des KfZ-Registers. Postalische und telefonische Befragung erreichten insgesamt mehr als 10 Millionen wahlberechtigte Amerikaner, von denen sich etwa 2,3 Millionen an der Stimmabgabe beteiligten – eine Stichprobe bisher unerreichten Umfangs (immerhin ein knappes Viertel der 45,6 Millionen späteren Wähler), von der man annahm, dass sie zu einer hochpäzisen Prognose des Wahlausgangs führen würde.

Auf der Basis dieser Ergebnisse prognostizierte der Literary Digest einen Erdrutschsieg für den Republikaner Landon (und titelte: „Landon in a Landslide!“), tatsächlich erhielt jedoch bekanntlich Roosevelt das Mandat für eine zweite Amtszeit. Und das mit einem enormen Vorsprung: Lediglich in zwei Bundesstaaten – Vermont und Massachusetts – konnte Landon die Wahl für sich entscheiden – einer der deutlichsten Wahlsiege der US-Geschichte. Insgesamt konnte Roosevelt 61% der Wählerstimmen und ganze 98% der „Wahlmänner” auf sich vereinen – von einem so deutlichen Sieg kann jeder der diesjährigen Kandidaten vermutlich nur träumen.

Die Blamage für das Magazin und der Riss in der eigenen Glaubwürdigkeit waren so gewaltig, dass die Leserschaft in den Folgejahren rapide abnahm und der Literary Digest schließlich eingestellt werden musste. Doch wie konnte es zu dieser geradezu unfassbar schlechten Wahlprognose, dieser bis dato größten Blamage der Wahlforschung kommen?

Ursachenforschung

Im wesentlichen sind zwei Verzerrungseffekte für die enorme Abweichung des vorhergesagten vom tatsächlichen Wahlergebnis verantwortlich. Bei der Planung der Telefonbefragung wurde tatsächlich außer Acht gelassen, dass Telefone 1936 noch längst nicht flächendeckend verfügbar waren und sich das Merkmal „Telefoninhaber” keineswegs zufällig in der Gesamtbevölkerung verteilte. Der Großteil aller Anschlüsse befand sich in einkommensstarken Haushalten, die traditionell dem konservativ-republikanischen Lager zuneigen (dies hat sich bekanntlich bis heute kaum geändert). Ähnliches gilt für das KfZ-Register, denn auch die Mehrheit der Automobilinhaber stammte 1936 noch aus einkommensstarken Schichten. Trotzdem fand keine Gewichtung der Ergebnisse statt, um den überproportionalen Anteil republikanischer Wähler auszugleichen, so dass sich der Bias im Auswahlverfahren auf das Endergebnis auswirken konnte.

Als Erkenntnis aus diesem, ersten Fehler ist demnach festzuhalten, dass auch eine korrekt durchgeführte Zufallsauswahl nicht zu einer brauchbaren Stichprobe führt, wenn sie aus einer Teilmenge der Grundgesamtheit entnommen wird, in der hinsichtlich der untersuchten Merkmale keine Strukturäquivalenz zur Grundgesamtheit besteht – wie eben bei den Telefonverwendern und den Wahlberechtigten. Dieses Problem ist dank der Online-Marktforschung heute wieder hochaktuell (Stichwort: Panelrekrutierung), wozu ich aber im Fazit noch etwas schreiben werde.

Die zweite Verzerrung trat im Bereich der schriftlichen Befragung auf. Der überwiegende Anteil der 10 Millionen angesprochenen Wahlberechtigten wurde über die Stimmzettel erreicht, doch nur etwas mehr als 20% der Angesprochenen beteiligten sich auch an der Stimmabgabe. Da das Merkmal „Motivation zur Teilnahme” in der Regel nicht zufällig in einer beliebigen Gruppe von angesprochenen Personen verteilt ist, sondern mit anderen Merkmalen zusammenhängt, ist dadurch, dass die Probanden selbst entscheiden, ob sie zur Stichprobe gehören, eine Verzerrung zu erwarten. Die Stichprobe konstituiert sich in solchen Fällen gewissermaßen selbst, ein Vorgang, der als Selbstselektion bezeichnet wird und der in der Regel zu starken Verzerrungen führt.

Aus der Geschichte lernen

Welche Lehren ergeben sich nun für nun die Markt- und Meinungsforscher von heute aus dem „Literary Digest Disaster” von 1936?

Zunächst einmal lässt sich feststellen, dass keiner der beiden negativen Effekte durch den großen Umfang der Stichprobe abgemildert wurde. Dies bedeutet, dass methodische Probleme bei der Teilnehmerauswahl, die zu einer verzerrten Stichprobe führen, nicht durch die Vergrößerung der Stichprobe ausgeglichen werden können. Die Annahme „je größer die Stichprobe, desto zuverlässiger das Ergebnis der Untersuchung” gilt daher nur dann, wenn der Untersuchung eine statistisch saubere Zufallsauswahl zugrunde liegt. Ist dies einmal nicht der Fall, kann man sich dennoch leicht dazu verführen lassen, die Ergebnisse einer Erhebung allein aufgrund der Stichprobengröße für aussagekräftig zu halten.

Genau dieses Problem kann man heute wieder in der Online-Marktforschung beobachten. Im Gegensatz zur traditionellen Marktforschung wird im Online-Bereich viel mit selbstselektiven Stichproben gearbeitet („Hier klicken, um an unserer Befragung zum Thema XYZ teilzunehmen”). Da es im Internet zudem sehr einfach und kostengünstig ist, größere Stichproben mit beeindruckenden Teilnehmerzahlen im Tausender-Bereich zusammenzustellen, wird häufig auch bei selbstselektiven Erhebungen mit der Größe der zugrundeliegenden Stichprobe geworben. Durch die Hervorhebung der Stichprobengröße wird diese den Konsumenten gegenüber implizit als Indikator für Qualität und Repräsentativität der Ergebnisse präsentiert – und das ist verkehrt.

In der Online-Marktforschung sehen wir uns daher mit ganz ähnlichen Problemen konfrontiert, wie die Damen und Herren des Digest im Jahre 1936. Die ADM, ein Zusammenschluss deutscher Markt- und Meinungsforscher, weist darauf übrigens schon seit Jahren hin – und auch wenn sich die Situation (zumindest bei den professionellen Instituten) sehr gebessert hat, findet man im Netz noch immer genügend Studien mit selbstselektivem Charakter, die mit hohen bis sehr hohen Befragtenzahlen werben.

Auch lassen sich gewisse Parallelen zwischen dem Telefonpanel von 1936 und heutigen Online-Panels erkennen. Ebenso wie Telefonanschlüsse um 1936 noch längst nicht in allen Haushalten zu finden waren, ist auch der Besitz eines Internetanschlusses heute noch keine Selbstverständlichkeit, sondern hängt mit einer Reihe vornehmlich sozio-ökonomischer Faktoren zusammen. Vor allem Personen mit hohem Einkommen und hoher Bildung sowie junge Menschen sind stark im Internet vertreten und damit auch in den meisten Panels „überrepräsentiert”. Laut Forschungsgruppe Wahlen haben insgesamt etwa 64% aller Deutschen aktuell Zugang zum Internet. Damit ist klar, dass ein bevölkerungsrepräsentative Online-Erhebungen im Grunde nicht geben kann – und sowohl die Größe der Stichprobe als auch die „saubere” Zufallsauswahl aus einem Online-Panel lassen sich mit Verweis auf das Literary Digest Disaster leicht als Scheinargumente entlarven.

Es ist gewiß eine kleine Ironie der Geschichte, dass ein im Grunde schon lange erkanntes und bekanntes Problem wie die Selbstselektivität heute wieder eine Rolle spielt – wenn auch nicht in der Wahlforschung, wo man auf selbstselektive Stichproben schon lange verzichtet. Es ist daher auch nicht damit zu rechnen, dass das Time Magazine dieser Tage McCain oder Obama verfrüht zum Präsidenten kürt – wer sich jedoch beruflich mit Ergebnissen der Online-Marktforschung befassen muss, sollte stets kritisch hinterfragen, auf welche Weise die Auswahl der Probanden vorgenommen wurde. Wenn man dies nicht beachtet, erweist sich das vermeintliche Star-Produkt oder der Mega-Werbespot am Ende vielleicht ebenso als lahme Ente wie Landon bei der Wahl von 1936….

Übrigens: 1936 gelangte auch ein späterer Pionier der Markt- und Meinungsforschung zu erstem Ruhm. Der junge George Gallup konnte anhand einer wesentlich kleineren Sichprobe von ein paar Tausend Wählern das sehr gute Abschneiden von Roosevelt korrekt prognostizieren – ganz im Gegensatz zu den Statistikern des Digest. Im Ergebnis gibt es den Digest heute bekanntlich nicht mehr – den Gallup Poll dagegen kennt jeder, der sich mit Statistik und Marktforschung auseinandersetzen muss.

Wo lässt sich diese Geschichte nachlesen?

Wer sich für die Problematik näher interessiert, dem sei mein im letzten Jahr veröffentlichtes Paper zum Thema empfohlen (in dem zugegebenermaßen aber auch nicht mehr steht als in diesem Blogartikel), außerdem ein von Hauptmanns und Lander verfasstes Kapitel in einem Herausgeberband zum Thema Online-Marktforschung sowie ein älteres aber dafür viel und gern zitiertes Paper von Bryson über das Literary Digest Disaster:

Reinboth, C.: Auswirkungen der Stichprobengröße auf die Repräsentativität von Online Befragungen, in: G. Beibst (Hrsg.): Tagungsband zur 8. Nachwuchswissenschaftlerkonferenz mitteldeutscher Fachhochschulen, S. 239-240, Jena, 2007, ISBN: 3-932886-15-1.

Hauptmanns, P. & Lander, B.: Zur Problematik von Internet-Stichproben. In A. Theobald, M. Dreyer & T. Starsetzki (Hrsg.), Online-Marktforschung (S. 27-40). Wiesbaden: Gabler, 2003.

Bryson, M. C., 1976: The Literary Digest: Making of a Statistical Myth. The American Statistician 30: 184-185.

Online: “Landon in a Landslide: The Poll that changed Polling” auf HistoryMatters:

https://historymatters.gmu.edu/d/5168/

Letzte Kommentare