In vielen Wissenschaften, so auch in den Gesundheitswissenschaften, ist der p-Wert ein statistisches Universalwerkzeug. Man entscheidet damit darüber, ob da etwas ist oder nicht.

Kurz zur Rekapitulation: Der p-Wert bezeichnet bekanntlich die Wahrscheinlichkeit, mit der beim Testen einer Hypothese, z.B. dass ein Medikament wirkt, ein bestimmtes Messergebnis zustande kommt, obwohl die Hypothese nicht zutrifft und nur der Zufall am Werk ist. Dass da nichts ist außer Zufall nennt man „Nullhypothese“, sie will man ablehnen. Als Konvention gilt für die Bewertung des Ergebnisses in den Gesundheitswissenschaften häufig das 5 %-Niveau als Schwellenwert: Ist der p-Wert kleiner als 5 %, geht man davon aus, dass das Ergebnis als Zufallsergebnis hinreichend unwahrscheinlich ist, die Nullhypothese abgelehnt werden kann und wohl ein Effekt vorliegt. Den seltenen Fall, dass man einen Effekt annimmt, obwohl doch keiner da war, nennt man „Fehler 1. Art“. Manchmal testet man auch auf dem 1 %-Niveau, wenn man vorsichtiger sein will. Diese Schwellenwerte sind die berühmten „Signifikanzniveaus“, um die es in Sätzen wie „das ist statistisch signifikant“ geht.

In den Gesundheitswissenschaften hat man es in der Regel nicht mit strengen naturwissenschaftlichen Gesetzen zu tun, die exakte Vorhersagen ermöglichen. Stattdessen unterstellt man, dass sich hier „Gesetze“ als zentrale Tendenzen in einem Nebel von zufälligen Störeffekten zeigen. Ob das wissenschaftstheoretisch für alle Sachverhalte angemessen ist, sei einmal dahingestellt, ich will an dieser Stelle nur die „Denke“ dabei verdeutlichen. Da man also mit vergleichsweise großen Streuungen rechnet, haben sich das 5 %-Niveau bzw. das 1 %-Niveau in den Gesundheitswissenschaften bewährt – leider sind deswegen auch die meisten Studien falsch.

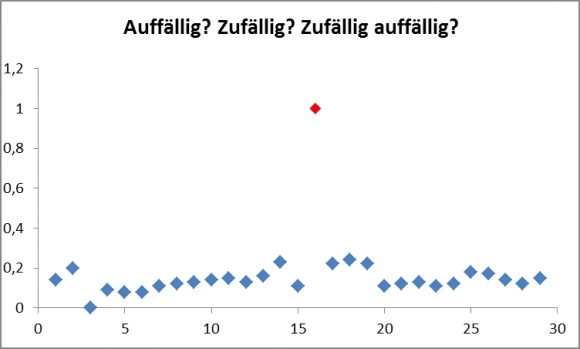

Das klingt natürlich reichlich paradox, aber so ist die Sachlage nun mal. Die wissenschaftliche Fachliteratur ist voll von statistisch signifikanten Ergebnissen, die in den Müll gehören. In einer Welt, in der wie wild alles Mögliche untersucht wird und Hypothesen getestet werden, was das Zeug hält, ist der an sich seltene Fall eines Ergebnisses, das als Zufallsergebnis nur in weniger als 5 % oder 1 % der Fälle zu erwarten war, leider an der Tagesordnung. Dagegen hilft kein p-Wert.

Die Krux mit dem p-Wert wird seit langem diskutiert, sehr schön z.B. in dem Bestseller „Der Hund, der Eier legt“ von Hans-Peter Beck-Bornholdt und Hans-Hermann Dubben. Aber so richtig etwas Besseres, als nicht blind auf die Vertrauenswahrscheinlichkeit zu vertrauen, ist noch keinem eingefallen.

In der Physik hat man es öfter mit Gesetzen zu tun, die sehr exakte Vorhersagen ermöglichen und bei denen man das Signal aus dem statistischen Rauschen der Messergebnisse mit viel niedrigeren p-Werten herausfischen kann. In der Physik arbeitet man z.B. oft mit einem Signifikanzniveau von 5 Sigma, das entspricht einer Schwelle für den p-Wert von 3×10-7, d.h. ein Ergebnis soll durch Zufall nicht öfter als einmal in etwa 3,5 Millionen Fällen auftreten.

In der aktuellen Ausgabe 12/2017 des Laborjournals hat nun Ulrich Dirnagl, Professor an der Berliner Charité, genau diese für die Gesundheitswissenschaften geradezu unvorstellbaren Signifikanzniveaus benutzt, um zu zeigen, dass man sich selbst darauf nicht blind verlassen kann. 2011 ging ein Experiment am CERN durch die Medien, demzufolge Neutrinos schneller waren als das Licht. Die Ergebnisse waren statistisch signifikant auf dem genannten hohen Niveau. Den Physikern war aber klar, dass sie mit der Überwindung der Lichtgeschwindigkeit als Schranke für die Geschwindigkeit von materiellen Teilchen die in tausenden von Experimenten bestätigten Grundlagen der Physik nach Einstein revolutionieren würden und dass es daher wahrscheinlicher war, dass an der Sache irgendetwas nicht stimmt. So war es dann ja auch, ein Kabel war locker. Das Ergebnis kam in dem Fall also aufgrund eines systematischen Fehlers zustande, ein echter Effekt, aber nicht der, der die Physik revolutioniert hätte. Das Vorwissen, wie unwahrscheinlich der gemessene Effekt ist und dass man daher der Vertrauenswahrscheinlichkeit in dem Fall nicht einfach vertrauen durfte, führt zur Bayesschen Statistik, aber das ist eine andere Geschichte.

Neben dem „Fehler 1. Art“, also der fälschlichen Ablehnung der Nullhypothese, gibt es auch einen „Fehler 2. Art“, nämlich dass man die Nullhypothese nicht ablehnt, obwohl sie falsch ist, also einen tatsächlich existierenden Effekt übersieht. Streng genommen ist die Nichtablehnung der Nullhypothese kein „Fehler“, weil sie nicht als Annahme der Nullhypothese interpretiert werden darf. Sonst würde man die Nullhypothese umso leichter annehmen können, je strenger das Signifikanzniveau ist (weil damit ihre Ablehnung immer unwahrscheinlicher wird). Der „Fehler 2. Art“ verweist vielmehr auf Probleme der „Power“ einer Studie, also der Stichprobengröße, aber auch das ist eine andere Geschichte. Dirnagl führt in seinem Kommentar aus der Physik ein aktuelles Beispiel dafür an, dass man auch bei wiederholtem Fehlschlag eines Nachweises gut beraten sein kann, weiter zu suchen – wenn es gute Gründe dafür gibt: So wurden nach langer vergeblicher Mühe die Gravitationswellen gefunden.

Der p-Wert erspart also sicher nicht das Denken und er liefert auch sicher nicht automatisch verlässliche Ergebnisse. Die Big Data-Euphorie wird sich daran noch so manche blutige Nase holen. Abschließend sei noch der Bogen zu einem Dauerthema hier geschlagen, der Homöopathie. Für die einen ist sie ein Verstoß gegen alles, was die Naturwissenschaft an gut bestätigtem Wissen aufgehäuft hat und daher nicht „scientabel“, wie es Christian Weymayr einmal formuliert hat. Auch gelegentliche statistisch signifikante Befunde in epidemiologischen Studien stellen angesichts der minimalen a priori-Wahrscheinlichkeit für einen Effekt keinen Beleg für ihre Wirksamkeit dar. Der Fall Überlichtgeschwindigkeit also. Für die anderen muss sie wirksam sein, weil Hahnemann dafür bürgt, auch wenn man bis heute nichts wirklich nachweisen konnte. Der Fall Gravitationswellen. Und manchmal versinkt alles irgendwo dazwischen, wie bei der Frage, ob Fischkonsum einen Effekt auf die PISA-Ergebnisse hat. Drum prüfe, bevor man sich mit seiner Meinung bindet, ob sich nicht eine bessere findet.

Kommentare (25)