In meiner Sommerpause schrieb mir ein lieber Kollege, dass ihm zu “Klicken bis die Kurve stimmt” noch HARKing (Hypothesizing After the Results are Known)[Kerr, 1998] einfiele. Den Begriff hatte ich zwar schon ab und an gehört, schließlich habe ich PostDoc-Zeit unter Statistikern verbracht, aber

- habe ich wenig darüber nachgedacht

- zeigte mir ein anderer Artikel, dass es zum Thema Reproduzierbarkeitskrise wesentlich schwerere Brocken gibt

- war die Erkenntnis aus 2 hinreichend um doch noch eine ständige Serie aufbauen zu können (wenngleich nicht sie nicht im selben Tempo immer weiter wachsen wird, bei bei den letzten Beiträgen)

HARKing also

HARKing ist eine Spielart der “post mortem-Statistik”, also des Munter-Daten-Sammels-und-dann-Überlegens. Guten ExperimentatorInnen und StatistikerInnen überkommt hierbei oft das Grausen: Wer sich vor der Datenerhebung Gedanken macht kann Überlegungen zur statistischen Power einfliessen lassen, ggf. Vorab-Experimente oder Vorab-Stichproben erheben, um die Natur der Daten kennenzulernen (z. B. zur Frage welcher Verteilung diese Daten gehorchen) und daraufhin die geeignete statistische Methode zu wählen. Vor allem aber gilt es bei diesem Vorgehen vorab eine (Null-)Hypothese zu formulieren, die man experimentell überprüfen möchte.

Vereinfacht gesagt ist das beim HARKing anders: Erst nach Augenschein der Daten wird die Hypothese formuliert oder gar zuvor formulierte Hypothese zugunsten einer anderen über den Haufen geworfen.

Und? Warum sollte mich das (als gute(r) WissenschaftlerIn) stören?

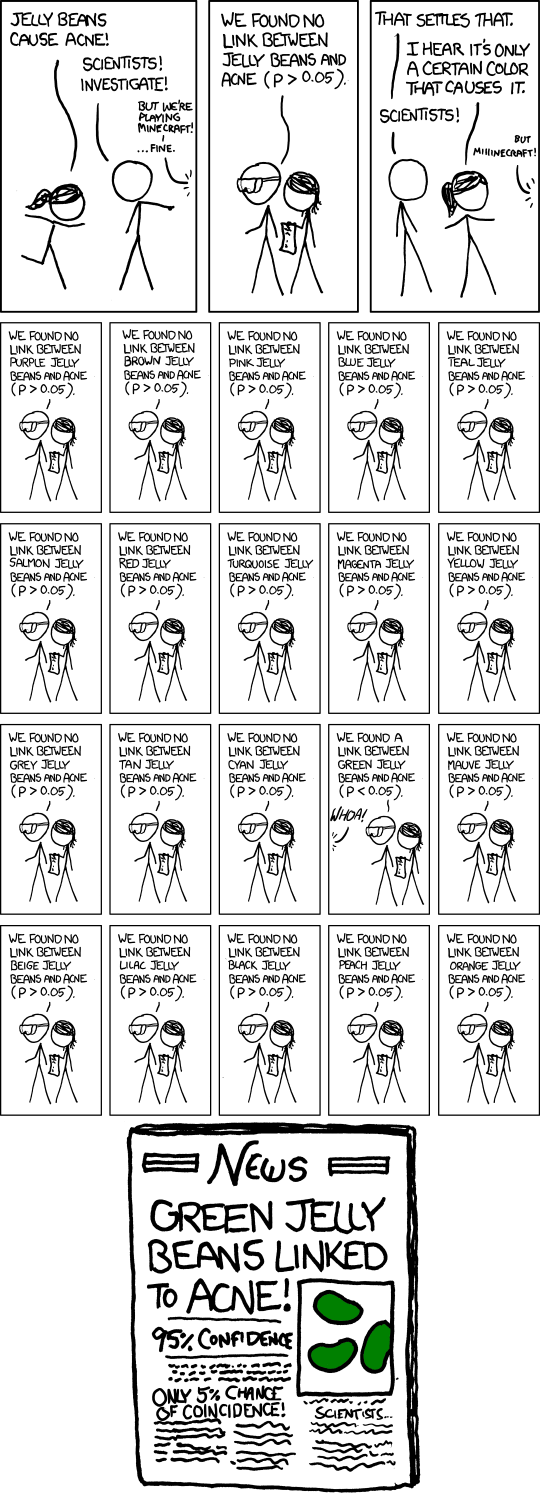

Das xkcd-comic zu den green jelly beans ist inzwischen ziemlich bekannt.

Wer den Witz nicht versteht möge bei explainxkcd.com nachlesen.

Wer also, insbesondere mit ausreichend großer Toleranz beim Fehler 1. Art, nur häufig genug bzw. mit ausreichend kleinen Stichproben testet findet ziemlich sicher einen “publizierbaren” p-Wert. Diese Unterart des p-Hacking ist immerhin gut bekannt und stark verpönt.

HARKing, kann man gewissermaßen als Komplementärmethode des unsauberen wissenschaftlichen Arbeitens auffassen – doch so einfach ist die Sache nicht, es gibt nämlich verschiedene Unterarten:

- das reine HARKing, wie von Kerr beschrieben. Hier wird die Hypothese erst nach Sichten der Daten aufgestellt und “statistisch untermauert”. Vielleicht muss man tatsächlich dazu schreiben, warum das wissenschaftlich unsauber ist: Wenn ich eine Hypothese erst nach Gewinnung der Daten aufstelle, werden die Daten wahrscheinlich meiner Hypothese “gehorchen”. Was wenn meine Daten aber einer zufälligen Schwankung unterliegen? Hätte ich nicht anders erheben / auswählen müssen? Ggf. mit mehr Datenpunkten? Unabhängig erhoben? Sehe ich also eher eine falsche Bestätigung meiner Annahmen?

- THARKing[Hollenbeck und Wright, 2016]: Transparently hypothesizing after the results are known – das ist eine wissenschaftlich saubere Form des HARKing. Schließlich ist nichts dabei eine Hypothese durch die Daten widerlegt zu sehen und transparent eine neue oder angepasste Hypothese aufzustellen. Man darf dann auch statistisch “Herumspielen” und schauen was die Statistik zur neuen Hypothese sagt – wenn das transparent ist, also in die Veröffentlichung geschrieben wird. Ideal ist, wenn dann noch beschrieben wird, wie man die neue Hypothese falsifizieren kann oder gar selber den Anlauf durch die erneute Erhebung von Daten oder erneuter Auswahl genommen hat.

- SHARKing[Hollenbeck und Wright, 2016]: Das Gegenteil von THARKing, also dem Verschweigen der ursprünglichen Hypothese (bzw. Unterdrücken derselben; das ‘S’ kommt von Supressing) und Präsentieren der neuen als a priori-Hypothese. Unschön aus denselben Gründen wie das reine HARKing, plus der Unlauterkeit gegen das Transparenzgebot bei wissenschaftlicher Arbeit verstoßen zu haben. Dieses kann auch als passives HARKing erfolgen. Damit sind wir wieder bei den Reviewern. Wenn Reviewer eine andere Sicht auf das Thema haben, können sie eine “bessere” Hypothese einfordern und so (S)HARKing veranlassen. Typischerweise wird dann die ursprüngliche Hypothese verschwiegen.

- RHARKing[Rubin, 2017]: das erneute Aufstellen von Hypothesen basierend auf bestehenden Erkenntnissen und des Präsentierens als a priori-Hypothesen. Die Hypothesen sind gewissermaßen äquivalent zu a priori-Hypothesen, weil ja so noch nicht getestet. Wenn man die eigene Daten- oder Literatursuche transparent macht und dann neue Daten erhebt ist das in Ordnung. Problematisch nur, wenn man auf alten Daten arbeitet und dann so tut als würde die “neue priori-Hypothese” einwandfrei bestätigt, denn die wurden unter Umständen mit zweifelhafter Qualität erhoben oder vielleicht nur teilweise publiziert – besser man erhebt neu und macht ALLES transparent.

Also, nicht jede Form des HARKing ist problematisch – THARKing kann man als gute wissenschaftliche Arbeit auffassen. Doch leider scheint ordinäres HARKing häufig[Rubin, 2017] und gar so häufig, dass es als Hauptbeitrag zur Reproduzierbarkeitskrise gewertet wird[Bishop, 2019].

Damit das Thema nicht so abstrakt bleibt und weil ich gerade Dorothy Bishop zitiere, hier mal das relativ aktuelle Gespräch zwischen Sabine Hossenfelder und Dorothy Bishop – selbstverständlich nicht nur über HARKing:

Was hilft?

Die sogenannte Vorerfassung wissenschaftlicher Studien oder registrierte Berichte, insbesondere in der Psychologie und bei klinischen Studien praktiziert, das Erfassen von wissenschaftlichen Absichten, die Beschreibung der Hypothesen in statistischer Sprache und die Beschreibung der Datenerfassung inklusive aller Protokolle kann Abhilfe schaffen. Wird dieser Weg beschritten braucht es einen verdammt guten Grund vom Protokoll abzuweichen und den gilt es anzugeben. Unter Umstände bedeutet dies auch eine erneute Fragestellung an die (Ethik-)Kommissionen. Vor allem aber können Reviewer damit keine angepassten Fragestellungen fordern und somit selber ein intransparentes HARKing induzieren.

Daneben aber sollten alle Studierenden in den quantitativ arbeitenden Fächern explizit mit den Auswirkungen und Ursachen der Replikationskrise konfrontiert werden. Am besten mit ein paar unterhaltsamen Beispielen. So wie in vielen Studiengängen Kurse zum wissenschaftlichen Schreiben Pflicht sind, sollten auch Kurse zur guten wissenschaftlichen Praxis verpflichtend werden. Das ist mancherorts bereits der Fall. Aber noch gibt es dicke Bretter zu bohren.

Weitere Vorschläge …

… zur Serie werden gerne angekommen. Mein Kollege meinte auch, ich könnte analog zu HARKing ein Akronym prägen. Also ich weiß nicht recht. Abgesehen davon, dass ich keinerlei unterfütternde Recherche unternommen habe und die Probleme im Umgang mit künstlicher Intelligenz vielschichtiger sind (darum ging es ja): CLUCIRing (CLicking Until the Curve Is Right) – ist aber absolut nicht eingängig, oder?

Kommentare (5)